Guanaco

基于QLoRA量化的LLaMA系列模型,将650亿参数规模大模型微调成本降到单张专业级显卡上。

基于QLoRA量化的LLaMA系列模型,将650亿参数规模大模型微调成本降到单张专业级显卡上。

模型发布时间: 2023-06-23

模型发布机构: 华盛顿大学自然语言处理小组

模型所属类型: 自然语言处理

模型官方地址: https://github.com/artidoro/qlora

Guanaco是华盛顿大学NLP小组发布的QLoRA方法的预训练结果模型,基于LLaMA微调。包含4个版本:

| Guanaco模型名称 | Guanaco模型参数量 | 预训练结果地址 |

|---|---|---|

| Guanaco 65B | 650亿 | https://huggingface.co/timdettmers/guanaco-65b |

| Guanaco 33B | 330亿 | https://huggingface.co/timdettmers/guanaco-33b |

| Guanaco 13B | 130亿 | https://huggingface.co/timdettmers/guanaco-13b |

| Guanaco 7B | 70亿 | https://huggingface.co/timdettmers/guanaco-7b |

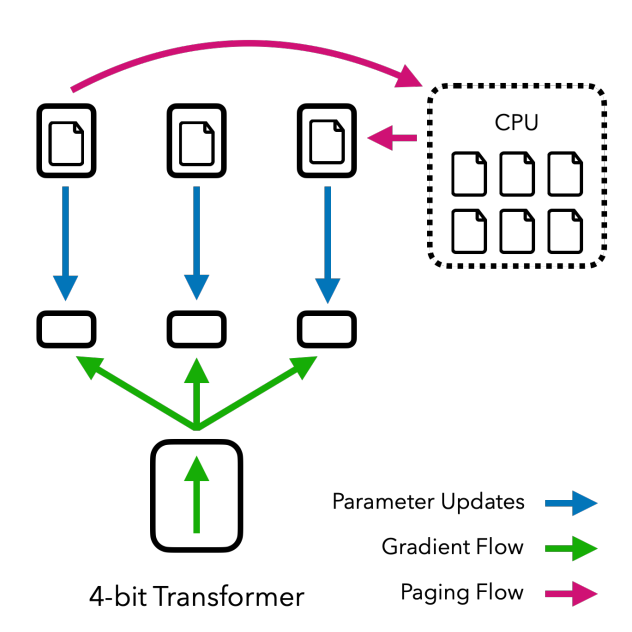

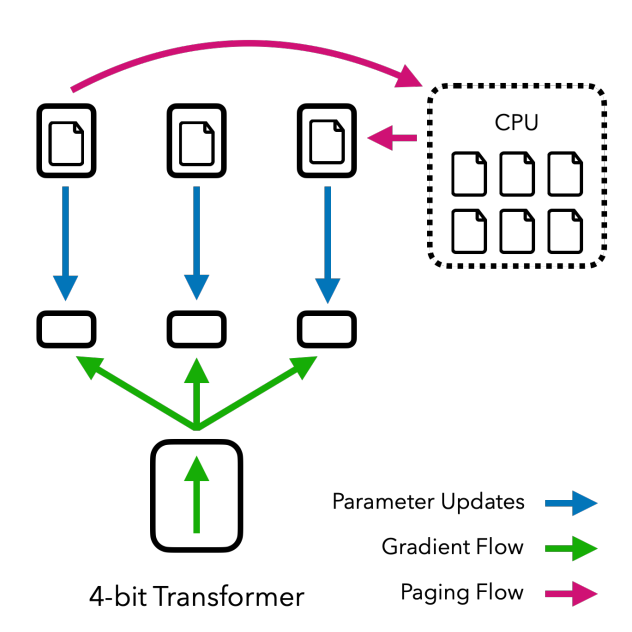

QLoRA是一种非常高效的大模型预训练技术,可以支持在单张专业级显卡微调650亿参数规模的大模型,具有很好的效果。QLoRA技术介绍: https://datalearner.com/blog/1051685029967582