Apollo-7B - Apollo-7B

模型详细情况和参数

Apollo-7B

- 模型全称

- Apollo-7B

- 模型简称

- Apollo-7B

- 模型类型

- 基础大模型

- 发布日期

- 2024-03-07

- 预训练文件大小

- 34GB

- 是否支持中文(中文优化)

- 是

- 最高支持的上下文长度

- 2K

- 模型参数数量(亿)

- 70.0

- 模型代码开源协议

- Apache 2.0

- 预训练结果开源商用情况

- Apache 2.0 - 免费商用授权

- 模型HuggingFace链接

- https://huggingface.co/FreedomIntelligence/Apollo-7B

- 在线演示地址

- https://apollo.llmzoo.com/

- 官方博客论文

- 暂无

- 基础模型

- 无基础模型

- 发布机构

Apollo-7B 简介

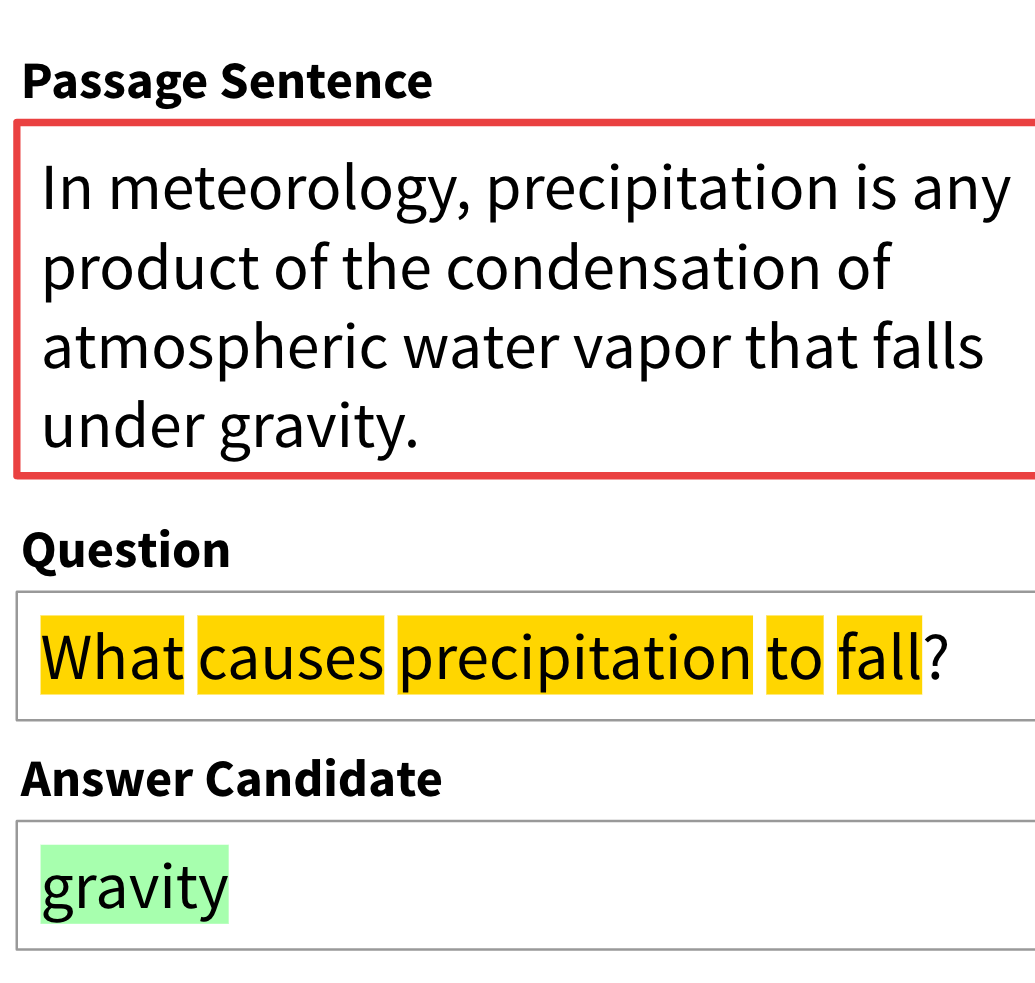

尽管庞大的全球医学知识库以英语为主,但当地语言对于提供量身定制的医疗保健服务至关重要,尤其是在医疗资源有限的地区。为了将医学人工智能的进步推广到更广泛的人群中,我们致力于开发六种使用最广泛的语言的医学 LLM,涵盖全球 61 亿人口。最终,我们创建了 ApolloCorpora 多语种医疗数据集和 XMedBench 基准。在多语言医疗基准测试中,已发布的 Apollo 模型在各种相对较小的规模(即 0.5B、1.8B、2B、6B 和 7B)下,在同等规模的模型中取得了最佳性能。特别是阿波罗-7B,它是最大可达 70B 的最先进的多语言医学 LLM。此外,这些精简模型还可用于提高大型模型的多语言医疗能力,而无需以代理调整的方式进行微调。我们将开源训练语料、代码、模型权重和评估基准。

欢迎大家关注DataLearner官方微信,接受最新的AI模型和技术推送

Apollo-7B所属的领域

Apollo-7B相关的任务