GLM-130B - GLM-130B

模型详细情况和参数

GLM-130B

- 模型全称

- GLM-130B

- 模型简称

- GLM-130B

- 模型类型

- 基础大模型

- 发布日期

- 2022-03-17

- 预训练文件大小

- 未知

- 是否支持中文(中文优化)

- 是

- 最高支持的上下文长度

- 2K

- 模型参数数量(亿)

- 1300.0

- 模型代码开源协议

- 不开源

- 预训练结果开源商用情况

- 不开源 - 不开源

- 模型GitHub链接

- https://github.com/THUDM/GLM-130B

- 模型HuggingFace链接

- https://huggingface.co/spaces/THUDM/GLM-130B

- 在线演示地址

- 暂无

- 基础模型

-

GLM

查看详情 - 发布机构

- 评测结果

-

评测名称 评测能力方向 评测结果

GLM-130B 简介

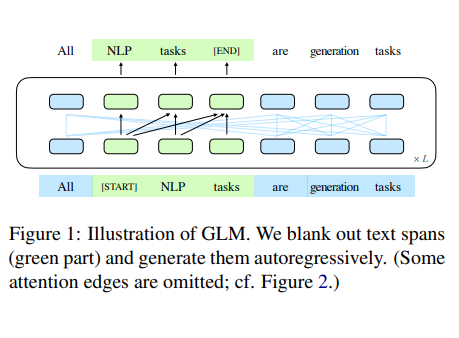

GLM-130B是清华大学基于GLM模型(模型卡: https://www.datalearner.com/ai-models/base-models/GLM )训练的一个1300亿超大参数规模的预训练大模型,这是一个开放的双语(英文和中文)双向密集模型,有1300亿个参数,使用通用语言模型(GLM)的算法进行预训练。它被设计用来支持在一台A100(40G*8)或V100(32G*8)服务器上的130B参数的推理任务。通过INT4量化,硬件要求可以进一步降低到4*RTX 3090(24G)的单台服务器,而且几乎没有性能下降。截至2022年7月3日,GLM-130B已经对超过4000亿个文本标记(中文和英文各2000B)进行了训练,它有以下独特的功能。

- 双语:同时支持英文和中文。

- 性能(EN):在LAMBADA上优于GPT-3 175B(+4.0%)、OPT-175B(+5.5%)和BLOOM-176B(+13.0%),在MMLU上略优于GPT-3 175B(+0.9%)。

- 性能(CN):在7个零次CLUE数据集(+24.26%)和5个零次FewCLUE数据集(+12.75%)上明显优于ERNIE TITAN 3.0 260B。

- 快速推理:支持用一台A100服务器对SAT和FasterTransformer进行快速推理(速度最高可达2.5倍)。

- 可复制性:所有结果(30多个任务)都可以通过开源代码和模型检查点轻松复制。

- 跨平台:支持在NVIDIA、Hygon DCU、Ascend 910和Sunway(将很快发布)上进行训练和推理。

需要注意的是,这个模型虽然开源,但是需要发邮件申请才能使用。不过这么大规模一般个人也很少申请。

硬件要求

| 显卡要求 | GPU显存 | 量化放十四 | 权重Offload |

|---|---|---|---|

| 8 * A100 | 40 GB | No | No |

| 8 * V100 | 32 GB | No | Yes (BMInf) |

| 8 * V100 | 32 GB | INT8 | No |

| 8 * RTX 3090 | 24 GB | INT8 | No |

| 4 * RTX 3090 | 24 GB | INT4 | No |

| 8 * RTX 2080 Ti | 11 GB | INT4 | No |

可以看到,这个配置真心不低啊!

欢迎大家关注DataLearner官方微信,接受最新的AI模型和技术推送