INT8 GPT-J 6B - INT8 GPT-J 6B

模型详细情况和参数

INT8 GPT-J 6B

- 模型全称

- INT8 GPT-J 6B

- 模型简称

- INT8 GPT-J 6B

- 模型类型

- 基础大模型

- 发布日期

- 2023-03-16

- 预训练文件大小

- 6

- 是否支持中文(中文优化)

- 否

- 最高支持的上下文长度

- 2K

- 模型参数数量(亿)

- 60.0

- 模型GitHub链接

- 暂无

- 模型HuggingFace链接

- 暂无

- 在线演示地址

- 暂无

- 官方博客论文

- 暂无

- 基础模型

-

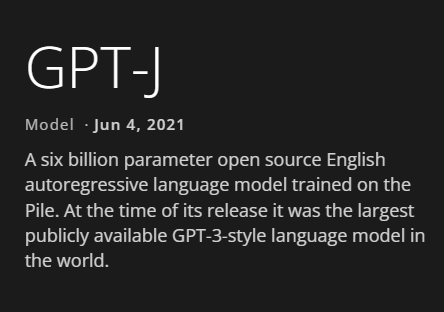

GPT-J

查看详情 - 发布机构

- 评测结果

-

评测名称 评测能力方向 评测结果

INT8 GPT-J 6B 简介

INT8 GPT-J 6B是GPT-J 6B的INT8量化版本,由Intel提供。

这个int8 ONNX模型是通过神经压缩器生成的,可以使用以下命令导出fp32模型:

python -m transformers.onnx --model=EleutherAI/gpt-j-6B onnx_gptj/ --framework pt --opset 13 --feature=causal-lm-with-past

测试结果如下:

| INT8量化 | FP32版本 | |

|---|---|---|

| Lamabda数据集准确率 | 0.7926 | 0.7954 |

| 模型大小(GB) | 6 | 23 |

可以看到,这个压缩版本使得模型从原来的23G压缩到了6G,但是准确率几乎没有下降,十分值得大家自己使用!

欢迎大家关注DataLearner官方微信,接受最新的AI模型和技术推送