LongForm LLaMA 7B - LongForm LLaMA 7B

模型详细情况和参数

LongForm LLaMA 7B

- 模型全称

- LongForm LLaMA 7B

- 模型简称

- LongForm LLaMA 7B

- 模型类型

- 基础大模型

- 发布日期

- 2023-04-26

- 预训练文件大小

- 28GB

- 是否支持中文(中文优化)

- 否

- 最高支持的上下文长度

- 2K

- 模型参数数量(亿)

- 70.0

- 模型GitHub链接

- https://github.com/akoksal/LongForm

- 模型HuggingFace链接

- https://huggingface.co/akoksal/LongForm-LLaMA-7B-diff

- 在线演示地址

- 暂无

- 基础模型

-

LLaMA

查看详情 - 发布机构

LongForm LLaMA 7B 简介

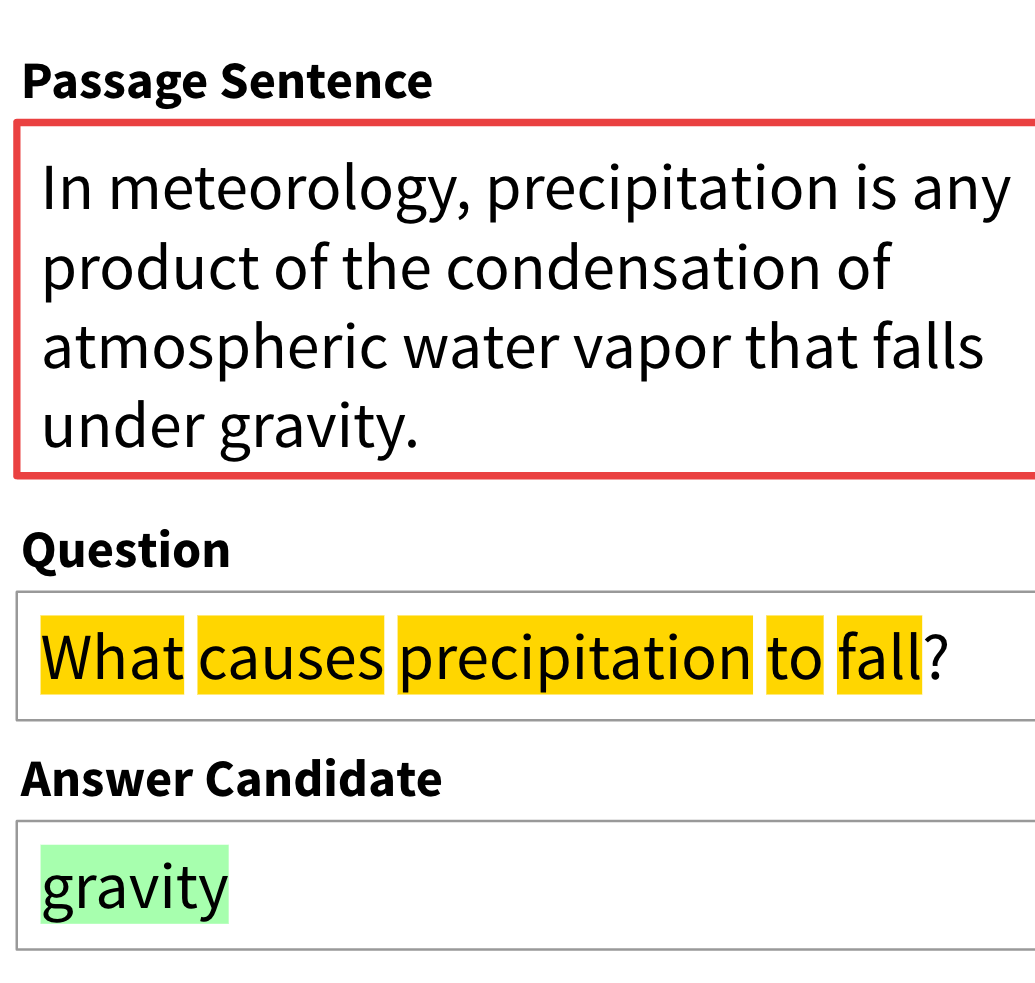

LongForm LLaMA 7B是慕尼黑大学研究人员基于LongForm数据集微调LLaMA模型的预训练大模型。LongForm是一系列指令微调数据集,包含27739条记录。这是通过使用LLM从数据集中生成指令后得到的指令微调数据集。是一种低成本高质量的指令微调数据集获取方法。

LongForm LLaMA 7B就是利用上述数据集,用LLaMA微调得到的。但是,由于LLaMA模型协议的限制,研究人员无法直接发布基于LLaMA微调的任何结果。因此,他们发布了一个diff模型:LongForm-LLaMA-7B-diff。

LongForm-LLaMA-7B-diff是一个预训练结果,但是这个预训练结果是LongForm-LLaMA-7B与原始LLaMA-7B模型的差异结果。也就是说不包含原始LLaMA的任意部分。这也是规避MetaAI模型开源限制的方法。使用的时候,需要先从MetaAI那里获取原始的LLaMA模型,然后再加载这个LongForm-LLaMA-7B-diff模型,将二者合并之后得到真正的LongForm LLaMA 7B模型后才能使用。

根据官方的测试,基于LongForm数据集微调的模型效果非常好:

| 模型名称 | 平均得分得分 | 菜谱生成得分 | ELI5得分 | Prompts撰写得分 |

|---|---|---|---|---|

| T0++ | 10.9 | 18.7 | 3.8 | 10.2 |

| Tk-Instruct | 6.3 | 12.9* | 3.6 | 2.4 |

| Flan-T5 | 10.6 | 20.9* | 3.5 | 7.4 |

| Alpaca-LLaMA-7B | 14.6 | 19.5 | 12.5 | 11.8 |

| OPT-30B | 11.1 | 18.6 | 12.2 | 2.6 |

| LongForm-T5-XL | 16.3 | 20.2 | 18.3 | 10.6 |

| LongForm-OPT-2.7B | 17.8 | 15.5 | 17.9 | 19.9 |

| LongForm-OPT-6.7B | 17.7 | 16.9 | 17.2 | 19.0 |

| LongForm-LLaMA-7B | 19.7 | 21.7 | 18.6 | 18.9 |

欢迎大家关注DataLearner官方微信,接受最新的AI模型和技术推送

LongForm LLaMA 7B所属的领域

LongForm LLaMA 7B相关的任务