Mixtral-8×22B-MoE - Mixtral-8×22B-MoE

模型详细情况和参数

Mixtral-8×22B-MoE

- 模型全称

- Mixtral-8×22B-MoE

- 模型简称

- Mixtral-8×22B-MoE

- 模型类型

- 基础大模型

- 发布日期

- 2024-04-17

- 预训练文件大小

- 262GB

- 是否支持中文(中文优化)

- 否

- 最高支持的上下文长度

- 64K

- 模型参数数量(亿)

- 1410.0

- 模型代码开源协议

- Apache 2.0

- 预训练结果开源商用情况

- Apache 2.0 - 免费商用授权

- 模型GitHub链接

- 暂无

- 模型HuggingFace链接

- https://huggingface.co/mistralai/Mixtral-8x22B-v0.1

- 在线演示地址

- 暂无

- DataLearnerAI的模型介绍

- Mistral正式官宣开源全球最大的混合专家大模型Mixtral 8x22B,官方模型上架HuggingFace,包含指令微调后的版本!

- 基础模型

- 无基础模型

- 发布机构

Mixtral-8×22B-MoE 简介

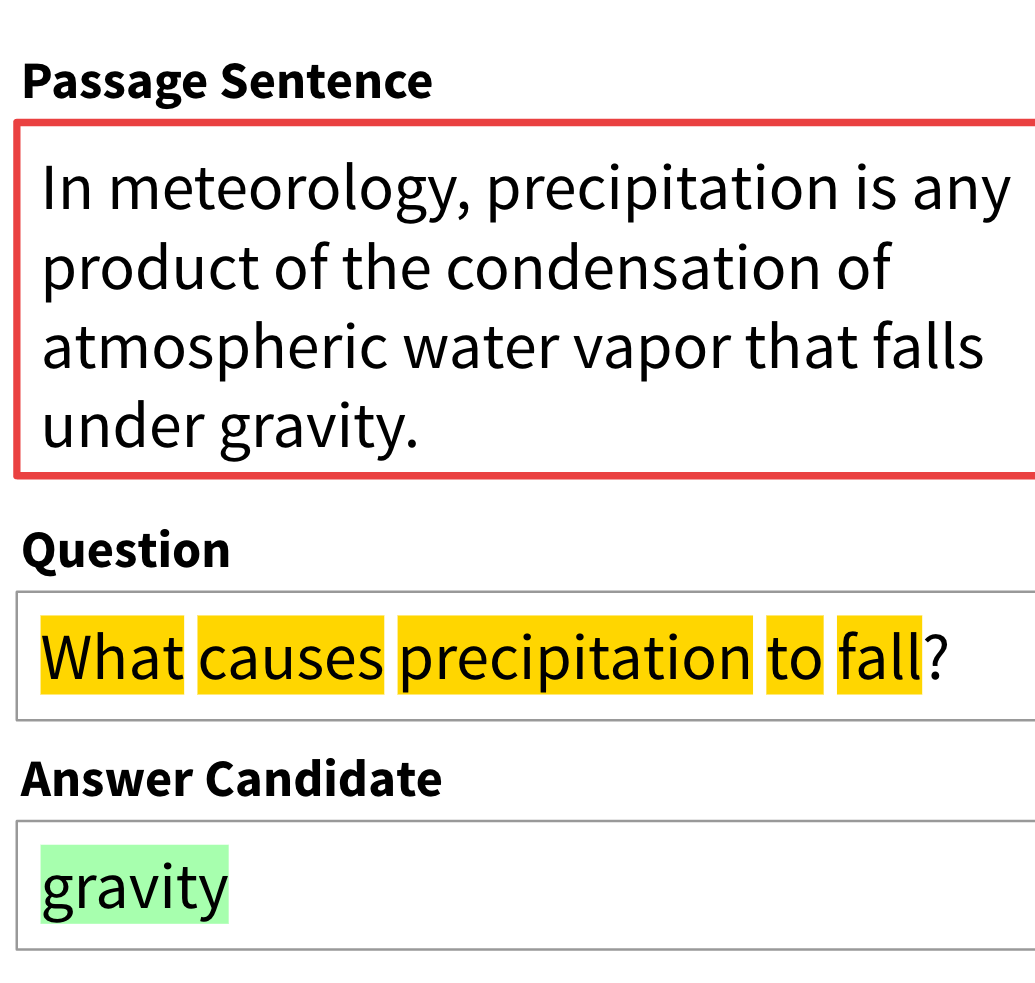

Mixtral-8×7B-MoE是由MistralAI开源的一个MoE架构大语言模型,因为它良好的开源协议和非常好的性能获得了广泛的关注。就在刚才,Mixtral-8×7B-MoE的继任者出现,MistralAI开源了全新的Mixtral-8×22B-MoE大模型。

目前该模型依然是以磁力链接让大家下载,没有提供任何新的消息,不过根据磁链文件信息,有几个简单的信息:

- Mixtral-8×22B-MoE依然是8个专家组成的混合专家大模型;

- 每个专家参数规模220亿,是原来70亿参数的3倍,因此总的参数量达到了1760亿!

- 如果依然是每次激活2个专家,这意味着每次推理的参数规模是440亿,比此前120亿参数规模大幅增加,有理由相信模型能力更强!

- Mixtral-8×7B-MoE模型的输入是32K,而这个模型的配置文件显示,上下文输入达到了64K!上下文长度翻倍!

- 根据这个参数估计,Mixtral-8×22B-MoE模型推理半精度的显存需要350GB!成本非常高!但是按照下载链接的物理文件达到262GB的话,应该是不到300G显存即可!

欢迎大家关注DataLearner官方微信,接受最新的AI模型和技术推送

Mixtral-8×22B-MoE所属的领域

Mixtral-8×22B-MoE相关的任务