Qwen-1.8B - Qwen-1.8B

模型详细情况和参数

Qwen-1.8B

- 模型全称

- Qwen-1.8B

- 模型简称

- Qwen-1.8B

- 模型类型

- 基础大模型

- 发布日期

- 2023-11-30

- 预训练文件大小

- 3.6GB

- 是否支持中文(中文优化)

- 是

- 最高支持的上下文长度

- 8K

- 模型参数数量(亿)

- 18.0

- 预训练结果开源商用情况

- Tongyi Qianwen RESEARCH LICENSE AGREEMENT - 免费商用授权

- 模型GitHub链接

- https://github.com/QwenLM/Qwen

- 模型HuggingFace链接

- https://huggingface.co/Qwen/Qwen-1_8B

- 在线演示地址

- 暂无

- 基础模型

- 无基础模型

- 发布机构

Qwen-1.8B 简介

阿里巴巴达摩院开源的18亿参数规模的大语言模型。

Qwen-1.8B模型是基座模型,阿里巴巴还开源了对齐后的聊天优化版本的Qwen-1.8B-Chat以及量化版本。具体的模型如下:

Qwen-1.8B基座模型: https://huggingface.co/Qwen/Qwen-1_8B

Qwen-1.8B-Chat的聊天的对齐优化模型: https://huggingface.co/Qwen/Qwen-1_8B

Int8量化版本的对齐优化模型Qwen-1.8B-Chat-Int8: https://huggingface.co/Qwen/Qwen-1_8B-Chat-Int8

Int4量化版本的对齐优化模型Qwen-1.8B-Chat-Int4: https://huggingface.co/Qwen/Qwen-1_8B-Chat-Int4

关于模型的介绍参考: https://www.datalearner.com/blog/1051701271552217

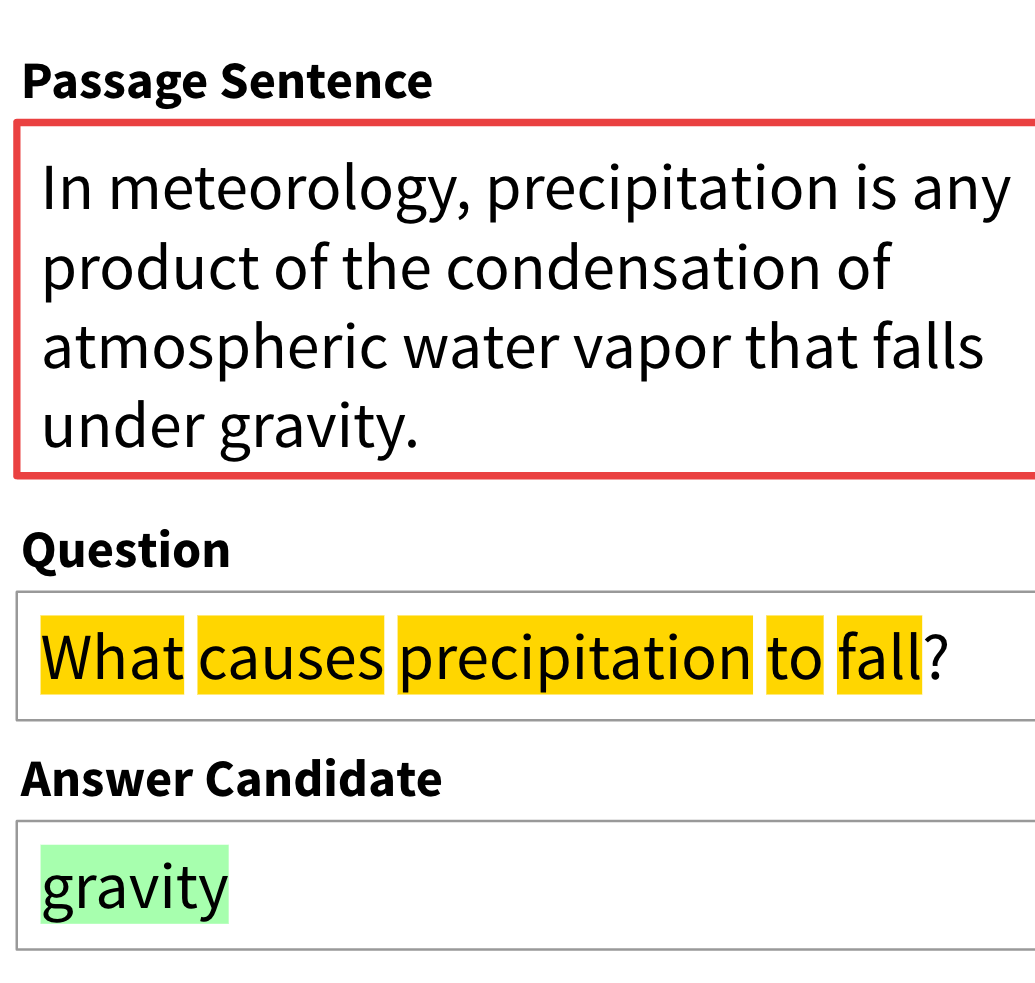

Qwen-1.8B模型的评测结果如下:

MMLU评测结果:

| Model | Avg. |

|---|---|

| GPT-Neo-1.3B | 24.6 |

| OPT-1.3B | 25.1 |

| Pythia-1B | 26.6 |

| Bloom-1.1B | 26.7 |

| Bloom-1.7B | 27.7 |

| Bloomz-1.7B | 30.7 |

| Bloomz-3B | 33.3 |

| Qwen-1.8B | 45.3 |

Qwen-1.8B模型的代码评测结果(HumanEval):

| Model | Pass@1 |

|---|---|

| GPT-Neo-1.3B | 3.66 |

| GPT-Neo-2.7B | 7.93 |

| Pythia-1B | 3.67 |

| Pythia-2.8B | 5.49 |

| Bloom-1.1B | 2.48 |

| Bloom-1.7B | 4.03 |

| Bloom-3B | 6.48 |

| Bloomz-1.7B | 4.38 |

| Bloomz-3B | 6.71 |

| Qwen-1.8B | 15.2 |

Qwen-1.8B模型的数学评测(GSM8K):

| Model | Acc. |

|---|---|

| GPT-Neo-1.3B | 1.97 |

| GPT-Neo-2.7B | 1.74 |

| Pythia-1B | 2.20 |

| Pythia-2.8B | 3.11 |

| Openllama-3B | 3.11 |

| Bloom-1.1B | 1.82 |

| Bloom-1.7B | 2.05 |

| Bloom-3B | 1.82 |

| Bloomz-1.7B | 2.05 |

| Bloomz-3B | 3.03 |

| Qwen-1.8B | 32.3 |

欢迎大家关注DataLearner官方微信,接受最新的AI模型和技术推送

Qwen-1.8B所属的领域

Qwen-1.8B相关的任务