Qwen-VL-MAX - Qwen-VL-MAX

模型详细情况和参数

Qwen-VL-MAX

- 模型全称

- Qwen-VL-MAX

- 模型简称

- Qwen-VL-MAX

- 模型类型

- 多模态大模型

- 发布日期

- 2024-01-25

- 预训练文件大小

- 0

- 是否支持中文(中文优化)

- 是

- 最高支持的上下文长度

- 2K

- 模型参数数量(亿)

- 0.0

- 模型代码开源协议

- 不开源

- 预训练结果开源商用情况

- 不开源 - 不开源

- 模型GitHub链接

- https://github.com/QwenLM/Qwen-VL

- 模型HuggingFace链接

- https://huggingface.co/spaces/Qwen/Qwen-VL-Max

- 在线演示地址

- 暂无

- 官方博客论文

- Introducing Qwen-VL

- 基础模型

- 无基础模型

- 发布机构

Qwen-VL-MAX 简介

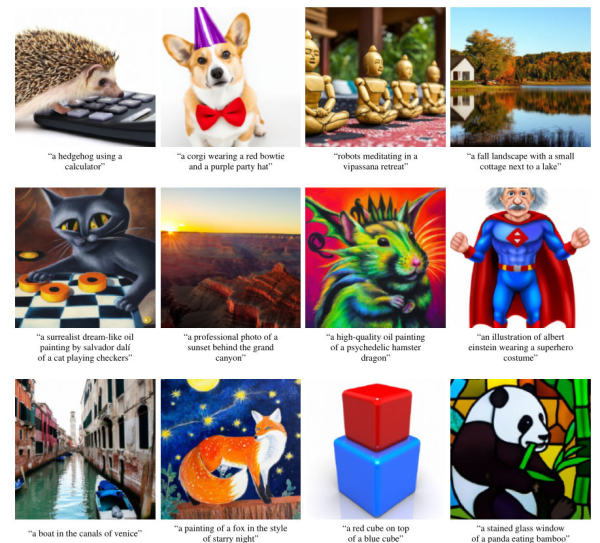

Qwen-VL-Max是阿里巴巴发布的一个多模态大模型,可以完成图片理解相关的任务,是Qwen-VL多模态大的模型系列最强的模型。但是,它没有公开任何模型相关信息。

Qwen-VL系列是阿里巴巴发布的多模态大模型系列,最早在2023年9月份发布,早期开源的版本是基于70亿参数的Qwen-7B语言模型基础上进行多模态数据训练得到。而后来又做了2个版本的增强,一个是Qwen-VL-Plus,另一个就是本次发布的Qwen-VL-Max。这两个模型相比较基础版本的模型都有了巨大的提升,但是并没有开源。具体来说,提升如下:

- 显著提高图像相关推理能力。

- 在识别、提取和分析图像及其中的文本方面有显著提升。

- 支持超过百万像素的高清图像和各种纵横比的图像。

其中Qwen-VL-Max是Qwen-VL系列中最强大的模型,进一步提高视觉推理和指令遵循能力,提供更高级别的视觉感知和认知理解。官方宣称Qwen-VL-Plus和Qwen-VL-Max在多个文本-图像多模态任务中与Gemini Ultra和GPT-4V相媲美,显著超越其他开源模型。Qwen-VL-Max在中文问答和中文文本理解任务中表现优于OpenAI的GPT-4V和Google的Gemini。

虽然官方没有开源模型,但是提供了免费使用的方式:

- Qwen-VL-Max在HuggingFace上的Demo地址: https://huggingface.co/spaces/Qwen/Qwen-VL-Max

- 目前官方也提供了免费的API接口: https://help.aliyun.com/zh/dashscope/developer-reference/tongyi-qianwen-vl-plus-api

欢迎大家关注DataLearner官方微信,接受最新的AI模型和技术推送

Qwen-VL-MAX所属的领域

Qwen-VL-MAX相关的任务