CogVLM - CogVLM

模型详细情况和参数

CogVLM

- 模型全称

- CogVLM

- 模型简称

- CogVLM

- 模型类型

- 多模态大模型

- 发布日期

- 2023-10-11

- 预训练文件大小

- 28GB

- 是否支持中文(中文优化)

- 是

- 最高支持的上下文长度

- 2K

- 模型参数数量(亿)

- 170.0

- 预训练结果开源商用情况

- Apache 2.0 - 免费商用授权

- 模型GitHub链接

- https://github.com/THUDM/CogVLM

- 模型HuggingFace链接

- https://huggingface.co/THUDM/CogVLM

- 在线演示地址

- 暂无

- 基础模型

- 无基础模型

- 发布机构

CogVLM 简介

CogVLM 模型是由清华大学与智谱 AI 共同开源的一款中文多模态大模型。该模型具有以下显著特点:

1. 深度视觉语言融合

CogVLM 并不简单地采用浅层对齐方式来融合视觉与语言。相反,它在 GPT 语言模型的各个层中均添加了可训练的视觉专家模块,这些模块包括 QKV 矩阵和 MLP 层。这种设计方式允许图像特征与文本特征在各层进行深度融合,确保在此过程中不会降低语言模型的自然语言处理能力。

2. 保留原始语言模型的 NLP 能力

CogVLM 中的语言模型部分参数是固定不变的,这些参数来源于预训练过的 Vicuna-7B 模型。这种设计确保了 CogVLM 与原始 Vicuna-7B 模型在自然语言生成能力上完全一致。

3. 领先的性能表现

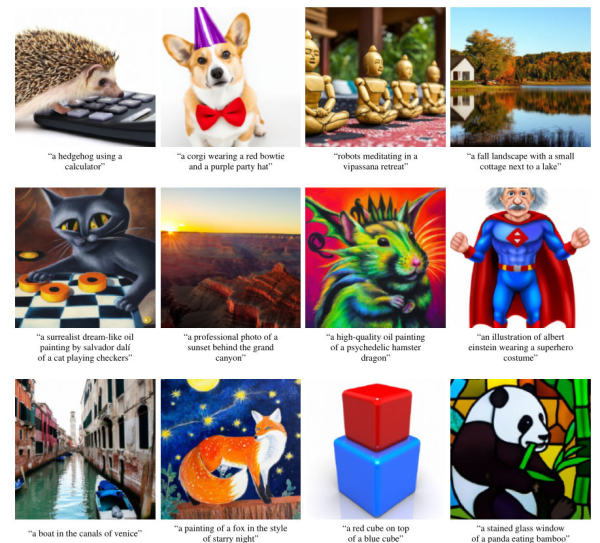

CogVLM 在多种视觉语言任务中均展现出了 state-of-the-art 的性能。这些任务包括但不限于图像字幕、视觉问答 (VQA)、视觉定位等 10 个经典的跨模态基准测试。

4、开源规模较大。

CogVLM-17B 是一个开源的大规模视觉语言基础模型,这个规模在业界还比较罕见。

CogVLM 的训练细节如下:

1、预训练:使用了约 15 亿张图像文本对进行两阶段预训练,第一阶段是图像字幕损失,第二阶段增加了指称表达理解 (REC) 任务。

2、对齐微调:使用约 50 万高质量 VQA 对进行监督微调,以对齐 CogVLM 到自由语言指令。得到 CogVLM-Chat 模型。

3、量化:采用量化技术压缩模型,使得可以部署在普通消费级 GPU 上。

总体来说,CogVLM 通过视觉专家模块实现深度视觉语言融合,在保持语言模型 NLP 能力的同时,获得了最优秀的视觉理解能力,是当前领先的开源视觉语言基础模型。

CogVLM的博客介绍

随着视觉语言技术的进步,越来越多研究者开始探索如何训练一个同时具备视觉理解和语言生成能力的基础模型。最近,一家商业 AI 公司开源了他们的视觉语言基础模型 CogVLM,作为一个强大的预训练模型基线,其性能达到了多个视觉语言任务的 state-of-the-art 水平。

CogVLM 的创新之处在于,它没有采用浅层对齐的方式把图像特征投影到语言模型的输入空间,而是在 GPT 语言模型的自注意力和前馈网络中加入了可训练的视觉专家模块。这种深度融合的方式使得 CogVLM 既保留了 GPT 本身的自然语言处理能力,又获得了卓越的视觉理解能力。

经过两阶段预训练和对齐微调后,CogVLM-17B 在 NoCaps、Flicker30K 字幕、RefCOCO 等 10 个经典跨模态任务上都取得了 state-of-the-art 的结果。与此同时,CogVLM 的 NLP 性能与原始语言模型 Vicuna-7B 完全一致。这使得 CogVLM 可以作为一个视觉增强的通用语言模型,同时处理视觉任务和语言任务。

另一个亮点是 CogVLM-17B 采用了开源许可,这在业界的视觉语言模型中还比较少见。相信这个强大的预训练模型基线会极大地推动视觉语言技术的研究和应用。

我自己也尝试了运行 CogVLM-Chat 模型,可以非常顺畅地跟模型进行视觉方向的问答和交互。模型对图像的理解细节很丰富,也很符合人类逻辑。相比许多视觉语言模型存在的“空想”问题,CogVLM 生成的回答非常地符合真实情况。

总之,CogVLM 是一个非常强大且开源的视觉语言基础模型,相信会有越来越多的研究者基于它进行迁移学习、增量训练等工作,使视觉 AI 的能力更进一步。它的开源发布也会推动相关技术更快地落地到产业应用当中。

欢迎大家关注DataLearner官方微信,接受最新的AI模型和技术推送

CogVLM所属的领域

CogVLM相关的任务