RecurrentGemma-2B - RecurrentGemma-2B

模型详细情况和参数

RecurrentGemma-2B

- 模型全称

- RecurrentGemma-2B

- 模型简称

- RecurrentGemma-2B

- 模型类型

- 基础大模型

- 发布日期

- 2024-04-09

- 预训练文件大小

- 5.37GB

- 是否支持中文(中文优化)

- 否

- 最高支持的上下文长度

- 8K

- 模型参数数量(亿)

- 27.0

- 模型代码开源协议

- Apache 2.0

- 预训练结果开源商用情况

- Gemma Terms of Use - 免费商用授权

- 模型GitHub链接

- https://github.com/google/gemma_pytorch

- 模型HuggingFace链接

- https://huggingface.co/google/recurrentgemma-2b

- 在线演示地址

- 暂无

- DataLearnerAI的模型介绍

- Google开源CodeGemma编程大模型和RNN架构大模型RecurrentGemma,同等参数规模最强编程大模型以及更快的大模型

- 基础模型

- 无基础模型

- 发布机构

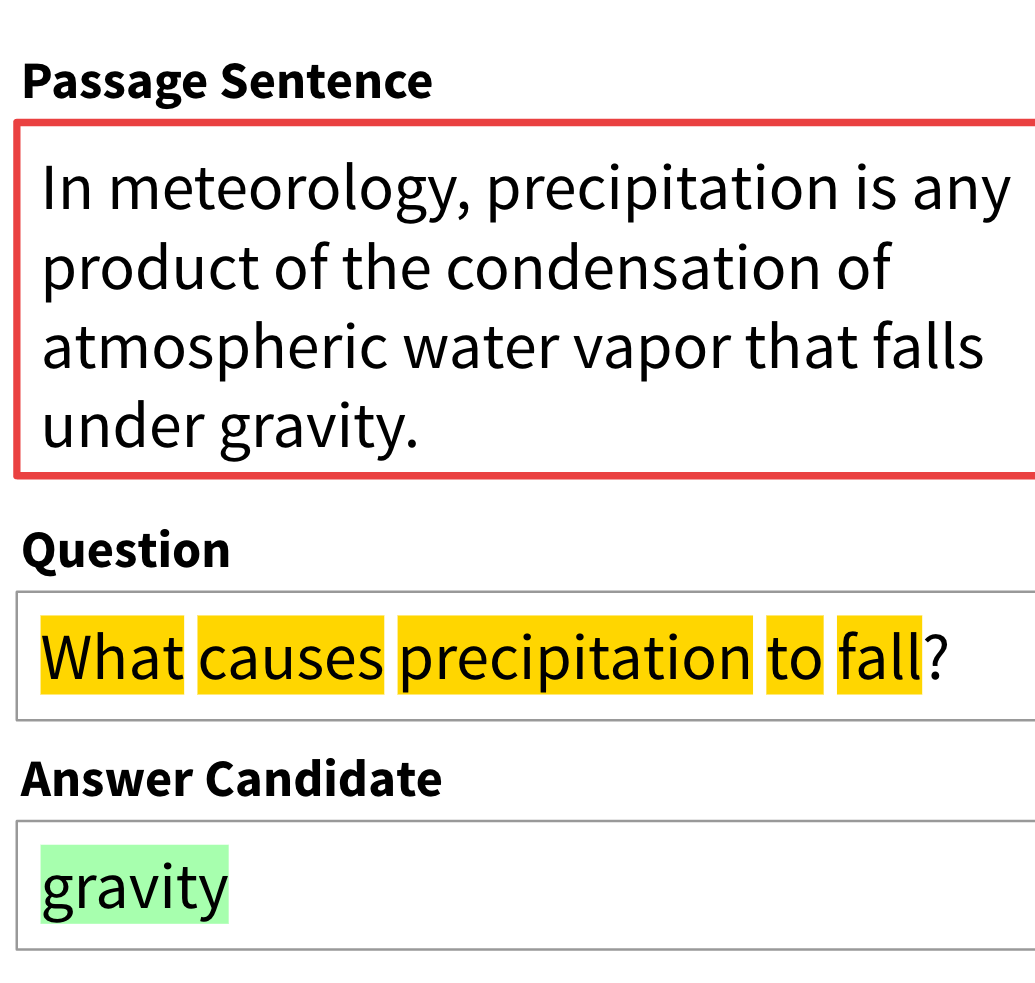

RecurrentGemma-2B 简介

RecurrentGemma是Google开源的一个一种新型的开源语言模型,具有以下主要特点和技术参数:

- 架构创新 - 采用了谷歌新提出的Griffin架构,结合线性递归单元(LRU)和局部注意力机制,而非传统的全局注意力。这种架构具有固定大小的状态,可降低内存使用并提高长序列的推理效率。

- 模型规模 - 发布了一个包含20亿非嵌入参数(总27亿参数)的2B版本。

- 预训练数据 - 使用与Gemma-2B相同的预训练语料,主要来自英文网页、数学和代码数据,总计2万亿标记数据(少于Gemma-2B的3万亿)。

- 指令微调 - 对预训练模型进行了指令微调,使其能更好地遵循指令和进行对话交互。

- 性能表现 - 在广泛的学术基准测试中,RecurrentGemma-2B的效果与Gemma-2B相当,尽管使用了更少的预训练数据。在人工评估中也表现出色,在指令执行任务上与7B的Mistral模型不相上下。

- 推理效率 - 由于固定状态大小,RecurrentGemma在长序列生成时推理速度明显快于Transformer,尤其是对单个TPU设备而言。

- 发布内容 - 发布了预训练检查点、指令微调检查点,以及高效的评估和微调代码(JAX和PyTorch实现)。

- 规模 - 词表大小25.6万,宽度2560,深度26层。

根据报告,RecurrentGemma模型最大的特点和价值主要体现在以下几个方面:

- 高效的长序列处理能力 - 通过使用Griffin架构结合线性递归单元和局部注意力,RecurrentGemma能够将输入序列压缩到固定大小的状态中,从而避免了Transformer架构中键值对缓存随序列长度线性增长的问题。这使得RecurrentGemma在处理超长序列时具有显著的内存优势,能够生成任意长度的序列而不受内存限制。

- 高推理效率 - 由于固定状态大小,RecurrentGemma在长序列生成时的推理速度明显快于同等规模的Transformer模型。报告展示,在TPU上,相比Gemma-2B,RecurrentGemma-2B在长序列生成任务上的吞吐量提高数倍。这种高效的推理能力使其更适用于对延迟和计算资源敏感的应用场景。

- 出色的下游任务表现 - 尽管使用了较少的预训练数据(2万亿 vs 3万亿标记),RecurrentGemma-2B在广泛的学术基准测试中表现与Gemma-2B相当,在指令遵从和对话任务的人工评估中也有优异表现,与7B的Mistral模型不相上下。这说明Griffin架构并未牺牲模型的语言理解和生成能力。

- 有效管理训练成本 - 相比Transformer,RecurrentGemma的固定状态使得在TPU等加速器上训练时能获得更高的加速比,从而降低总体的训练成本和资源需求。

总的来说,RecurrentGemma主要通过架构创新实现了在保持优异性能的同时,大幅提高了长序列处理能力和推理效率,这使其在许多应用场景下都具有较高的价值。

欢迎大家关注DataLearner官方微信,接受最新的AI模型和技术推送

RecurrentGemma-2B所属的领域

RecurrentGemma-2B相关的任务