大模型的发展速度很快,对于需要学习部署使用大模型的人来说,显卡是一个必不可少的资源。使用公有云租用显卡对于初学者和技术验证来说成本很划算。DataLearnerAI在此推荐一个国内的合法的按分钟计费的4090显卡公有云服务提供商仙宫云,可以按分钟租用24GB显存的4090显卡公有云实例,非常具有吸引力~

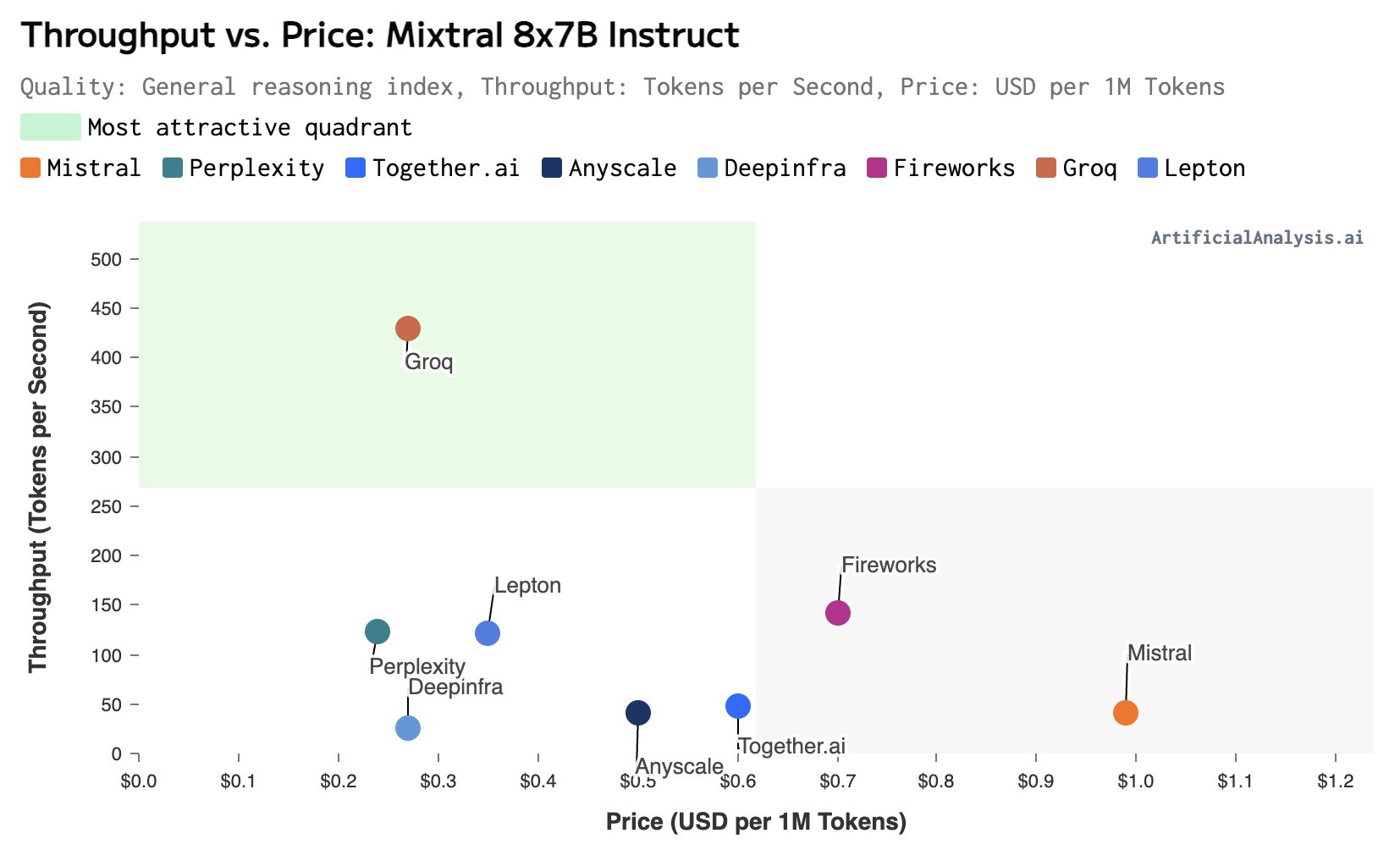

大模型的推理速度是当前制约大模型应用的一个非常重要的问题。在很多的应用场景中(如复杂的接口调用、很多信息处理)的场景,更快的大模型响应速度通常意味着更好的体验。但是,在实际中我们可用的场景下,大多数大语言模型的推理速度都非常有限。慢的有每秒30个tokens,快的一般也不会超过每秒100个tokens。而最近,美国加州一家企业Groq推出了他们的大模型服务,可以达到每秒接近500个tokens的响应速度,非常震撼。

今日推荐

Anthropic发布新一代Claude 3.5模型:全新的Haiku 3.5和升级版Sonnet 3.5

分解机(Factorization Machine, FM)模型简介以及如何使用SGD、ALS和MCMC求解分解机

张华平分词(又名中科院分词/NLPIR分词)的使用(Java版本)

OpenAI可能即将增加按年付费的选项,一年的ChatGPT Plus仅需200美元

可能比runway更好!StabilityAI最新开源文本生成视频大模型:Stable Video Diffusion,可以生成最多20帧的视频,但不可商用

平衡二叉树之AVL树(Adelson-Velsky and Landis Tree)简介及Java实现

大型语言模型的新扩展规律(DeepMind新论文)——Training Compute-Optimal Large Language Models