BERT - Bidirectional Encoder Representations from Transformers

模型详细情况和参数

BERT

- 模型全称

- Bidirectional Encoder Representations from Transformers

- 模型简称

- BERT

- 模型类型

- 基础大模型

- 发布日期

- 2018-10-11

- 预训练文件大小

- 1.3GB

- 是否支持中文(中文优化)

- 否

- 最高支持的上下文长度

- 2K

- 模型参数数量(亿)

- 3.4

- 模型代码开源协议

- Apache 2.0

- 预训练结果开源商用情况

- Apache 2.0 - 免费商用授权

- 模型GitHub链接

- https://github.com/google-research/bert

- 模型HuggingFace链接

- https://huggingface.co/docs/transformers/model_doc/bert

- 在线演示地址

- 暂无

- 基础模型

- 无基础模型

- 发布机构

Bidirectional Encoder Representations from Transformers 简介

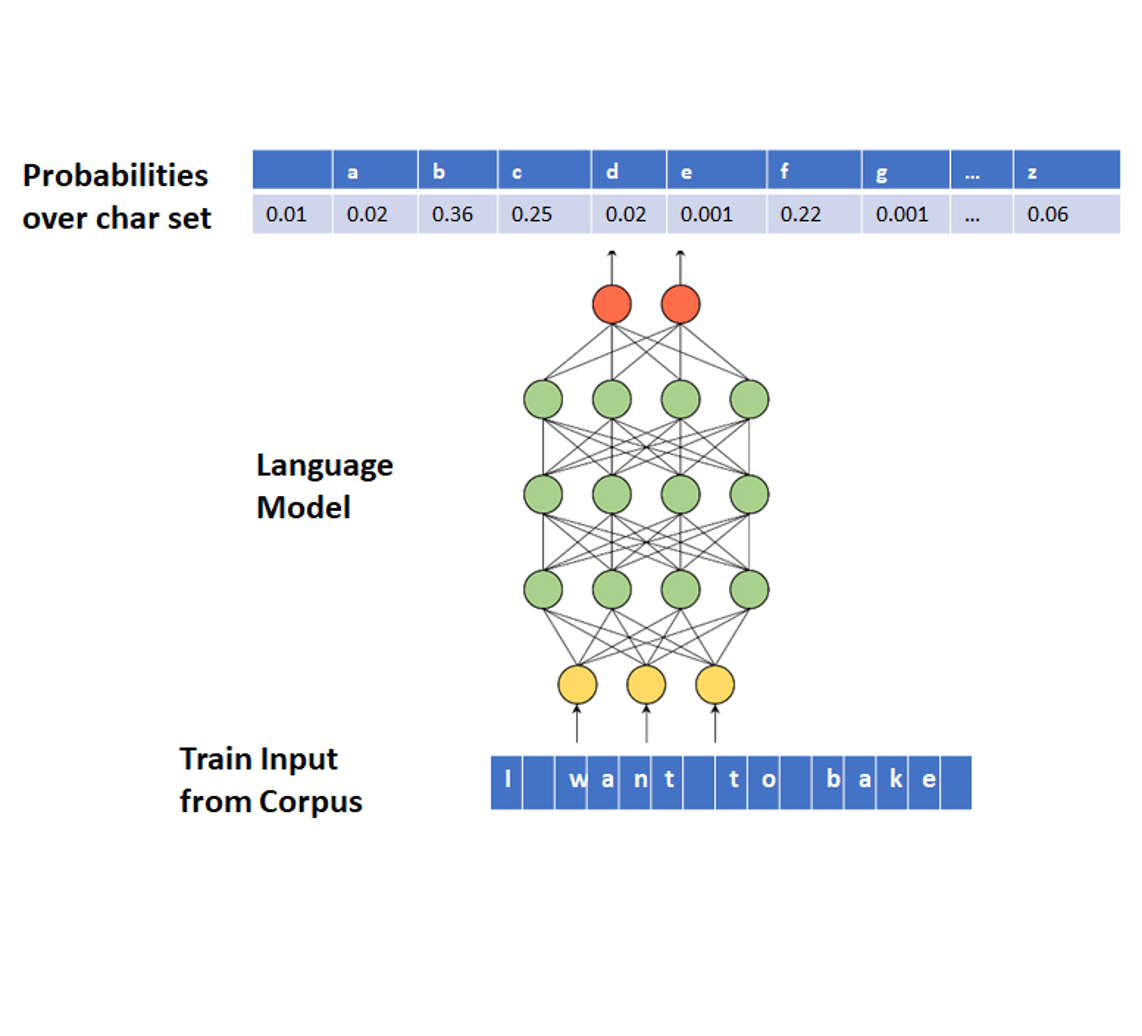

BERT (Bidirectional Encoder Representations from Transformers) 是一种基于深度学习的预训练模型,由Google在2018年发布。它是一种自然语言处理模型,用于将自然语言转换成机器可读的形式,例如对话系统、语音识别、文本分类、语言翻译、命名实体识别等。

BERT的主要贡献是在自然语言处理领域引入了预训练技术。传统的机器学习模型需要手动提取特征,而BERT不需要这样做。BERT使用Transformer网络架构,通过无监督的方式从海量文本数据中学习出通用的语言表示,可以应用于各种NLP任务。

BERT的训练分为两个阶段:预训练和微调。预训练阶段使用无标注的语料库,将模型训练成一个通用的语言表示模型。微调阶段则针对特定的任务使用标注数据进行微调。

BERT在许多NLP任务上取得了很好的效果,包括问答、文本分类、语言翻译等。其主要的优势是可以充分利用大量的无标注数据进行预训练,从而得到更好的通用表示。同时,BERT还采用了双向编码器,可以充分考虑上下文信息,使得模型在处理长文本时更为有效。

欢迎大家关注DataLearner官方微信,接受最新的AI模型和技术推送

BERT所属的领域

BERT相关的任务