ChatGLM2-6B-32K

聊天大模型ChatGLM2-6B-32K

发布时间: 2023-07-31 3

模型参数(Parameters)

60.0

最高上下文长度(Context Length)

32K

是否支持中文

支持

推理能力(Reasoning)

模型基本信息

是否支持推理过程

不支持

最高上下文输入长度

32K tokens

最长输出结果

暂无数据

模型类型

聊天大模型

发布时间

2023-07-31

模型预文件大小

11.8GB

开源和体验地址

官方介绍与博客

API接口信息

接口速度(满分5分)

暂无数据

接口价格

输入价格:

- 文本: 暂无数据

- 图片: 暂无数据

- 音频: 暂无数据

- 视频: 暂无数据

- Embedding: 暂无数据

输出价格:

- 文本: 暂无数据

- 图片: 暂无数据

- 音频: 暂无数据

- 视频: 暂无数据

- Embedding: 暂无数据

输入支持的模态

文本

输入不支持

图片

输入不支持

视频

输入不支持

音频

输入不支持

Embedding(向量)

输入不支持

输出支持的模态

文本

输出不支持

图片

输出不支持

视频

输出不支持

音频

输出不支持

Embedding(向量)

输出不支持

ChatGLM2-6B-32K模型在各大评测榜单的评分

发布机构

智谱AI

查看发布机构详情

模型介绍

ChatGLM2-6B-32K是智谱AI发布的基于ChatGLM2-6B的基础上微调的针对长上下文优化的大模型,能够更好的处理最多32K长度的上下文。

此前,ChatGLM2-6B刚发布的时候,官方宣称该模型最高支持32K长上下文输入,但是LM-SYS官方测试显示ChatGLM2-6B在超过8K长度时候表现很糟糕: 支持超长上下文输入的大语言模型评测和总结——ChatGLM2-6B表现惨烈,最强的依然是商业模型GPT-3.5与Claude-1.3 。

具体来说,ChatGLM2-6B-32K基于位置插值(Positional Interpolation)的方法对位置编码进行了更新,并在对话阶段使用 32K 的上下文长度训练。在实际的使用中,官方推荐如果上下文长度基本在 8K 以内,建议使用ChatGLM2-6B;如果需要处理超过 8K 的上下文长度,推荐使用ChatGLM2-6B-32K。

ChatGLM2-6B-32K是开源中英双语对话模型 ChatGLM2-6B 的加长版本,在保留了初代模型对话流畅、部署门槛较低等众多优秀特性的基础之上,ChatGLM2-6B-32k 引入了如下新特性:

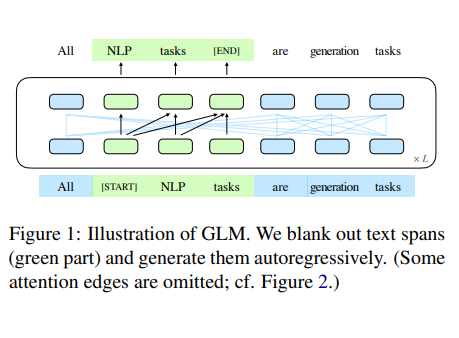

- 更强大的性能:基于 ChatGLM 初代模型的开发经验,我们全面升级了 ChatGLM2-6B-32K 的基座模型。ChatGLM2-6B-32K 使用了 GLM 的混合目标函数,经过了 1.4T 中英标识符的预训练与人类偏好对齐训练。

- 更长的上下文:基于 FlashAttention 技术,我们将基座模型的上下文长度(Context Length)由 ChatGLM-6B 的 2K 扩展到了 32K,并在对话阶段使用 32K 的上下文长度训练,允许更多轮次的对话。

- 更高效的推理:基于 Multi-Query Attention 技术,ChatGLM2-6B-32K 有更高效的推理速度和更低的显存占用:在官方的模型实现下,推理速度相比初代提升了 42%,INT4 量化下,6G 显存支持的对话长度由 1K 提升到了 8K。

- 更开放的协议:ChatGLM2-6B-32K 权重对学术研究完全开放,在填写问卷进行登记后亦允许免费商业使用。

Foundation Model

GLM

View Details关注DataLearnerAI公众号

关注DataLearnerAI微信公众号,接受最新大模型资讯