ChatGLM-6B

聊天大模型ChatGLM-6B

发布时间: 2023-03-14

模型基本信息

最高上下文输入长度

2K tokens

最长输出结果

模型类型

聊天大模型

发布时间

2023-03-14

模型预文件大小

8GB

开源和体验地址

官方介绍与博客

官方论文

DataLearnerAI博客

API接口信息

接口速度

接口价格

输入价格:

- 文本: 暂无数据

- 图片: 暂无数据

- 音频: 暂无数据

- 视频: 暂无数据

- Embedding: 暂无数据

输出价格:

- 文本: 暂无数据

- 图片: 暂无数据

- 音频: 暂无数据

- 视频: 暂无数据

- Embedding: 暂无数据

输入支持的模态

文本

输入不支持

图片

输入不支持

视频

输入不支持

音频

输入不支持

Embedding(向量)

输入不支持

输出支持的模态

文本

输出不支持

图片

输出不支持

视频

输出不支持

音频

输出不支持

Embedding(向量)

输出不支持

ChatGLM-6B模型在各大评测榜单的评分

发布机构

模型介绍

--------------2023/7/2 ChatGLM-6B 转为免费商用授权------------

ChatGLM-6B转为免费商用授权,申请地址: https://open.bigmodel.cn/commercial-auth

--------------2023/6/25 更新了第二代ChatGLM2-6B------------

第二代ChatGLM2-6B发布:

https://www.datalearner.com/ai-models/pretrained-models/ChatGLM2-6B

--------------2023/4/8 更新了一个最新的手把手本地部署ChatGLM-6B的教程------------

手把手教你本地部署清华大学KEG的ChatGLM-6B模型——Windows+6GB显卡版本和CPU版本的本地部署: https://www.datalearner.com/blog/1051680925189690

ChatGLM-6B是清华大学知识工程和数据挖掘小组(Knowledge Engineering Group (KEG) & Data Mining at Tsinghua University)发布的一个开源的对话机器人。根据官方介绍,这是一个千亿参数规模的中英文语言模型。并且对中文做了优化。本次开源的版本是其60亿参数的小规模版本,约60亿参数,本地部署仅需要6GB显存(INT4量化级别)。

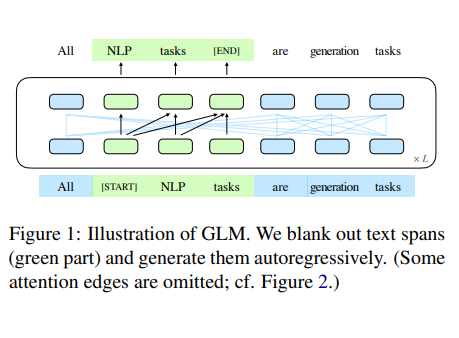

该模型的基础模型是GLM( GLM: General Language Model Pretraining with Autoregressive Blank Infilling ),是一个千亿基座模型,目前仅接受内测邀请。

根据测试,ChatGLM-6B虽然参数很少,但是效果很好。对于硬件的需求也很低。

ChatGLM-6B的推理和高效微调的硬件需求:

| 量化等级 | 最低 GPU 显存(推理) | 最低 GPU 显存(高效参数微调) |

|---|---|---|

| FP16(无量化) | 13 GB | 14 GB |

| INT8 | 8 GB | 9 GB |

| INT4 | 6 GB | 7 GB |

目前模型开源在GitHub上: https://github.com/THUDM/ChatGLM-6B

安装方法

从GitHub上下载整个工程,然后执行如下命令安装所需的库:

pip install -r requirements.txt

注意,该软件依赖HuggingFace的transformer,需要版本大于4.26.1(官方说实际上估计大于4.23.1版本都是可以的)

使用实例

>>> from transformers import AutoTokenizer, AutoModel>>> tokenizer = AutoTokenizer.from_pretrained("THUDM/chatglm-6b", trust_remote_code=True)>>> model = AutoModel.from_pretrained("THUDM/chatglm-6b", trust_remote_code=True).half().cuda()>>> response, history = model.chat(tokenizer, "你好", history=[])>>> print(response)你好?!我是人工智能助手 ChatGLM-6B,很高兴见到你,欢迎问我任何问题。>>> response, history = model.chat(tokenizer, "晚上睡不着应该怎么办", history=history)>>> print(response)晚上睡不着可能会让你感到焦虑或不舒服,但以下是一些可以帮助你入睡的方法:1. 制定规律的睡眠时间表:保持规律的睡眠时间表可以帮助你建立健康的睡眠习惯,使你更容易入睡。尽量在每天的相同时间上床,并在同一时间起床。2. 创造一个舒适的睡眠环境:确保睡眠环境舒适,安静,黑暗且温度适宜。可以使用舒适的床上用品,并保持房间通风。3. 放松身心:在睡前做些放松的活动,例如泡个热水澡,听些轻柔的音乐,阅读一些有趣的书籍等,有助于缓解紧张和焦虑,使你更容易入睡。4. 避免饮用含有咖啡因的饮料:咖啡因是一种刺激性物质,会影响你的睡眠质量。尽量避免在睡前饮用含有咖啡因的饮料,例如咖啡,茶和可乐。5. 避免在床上做与睡眠无关的事情:在床上做些与睡眠无关的事情,例如看电影,玩游戏或工作等,可能会干扰你的睡眠。6. 尝试呼吸技巧:深呼吸是一种放松技巧,可以帮助你缓解紧张和焦虑,使你更容易入睡。试着慢慢吸气,保持几秒钟,然后缓慢呼气。如果这些方法无法帮助你入睡,你可以考虑咨询医生或睡眠专家,寻求进一步的建议。代码实现: https://huggingface.co/THUDM/chatglm-6b

大家也可以使用他们基于Gradio的网页版本。为了让大家使用,他们也提供了CPU推理的方式,甚至16G内存的CPU也可以用(真为大家操碎了心)

ChatGLM-6B可以实现的能力

这是一个对话机器人,所以基本的问答系统都是支持的。官方提供了几个使用实例:

- 自我认知

- 提纲写作

- 文案写作

- 邮件助手

- 信息抽取

- 角色扮演

- 评论比较

- 旅游向导

注意,ChatGLM-6B模型的代码和预训练文件是开源的,但是预训练结果不可商用!

Foundation Model

GLM

View Details关注DataLearnerAI公众号

关注DataLearnerAI微信公众号,接受最新大模型资讯