AI大模型学习

原创AI博客

大模型技术资讯

大模型评测排行

大模型评测排行榜

大模型数学推理能力排行榜

大模型代码编程能力排行榜

大模型图片编辑能力排行榜

LMSys ChatBot Arena排行榜

Berkeley大模型工具使用能力排行榜

大模型综合能力排行榜(旧)

大模型编程能力排行榜(旧)

OpenLLMLeaderboard中国站

AI大模型大全

最新大模型列表

大模型部署教程

大模型对比工具

大模型评测基准

大模型评测基准

SWE Bench Verified

ARC-AGI-2

AIME 2025

FrontierMath-Tier4

MMMU

AI Agents列表

AI资源仓库

AI领域与任务

AI研究机构

AI数据集

AI开源工具

数据推荐

国产AI大模型生态全览

AI模型概览图

AI模型月报

AI基础大模型

AI工具导航

AI大模型工具导航网站

在线聊天大模型列表

Incorporating Domain Knowledge into Topic Modeling via Dirichlet Forest Priors

小木

ICML

2009-09

1934

2017/02/06 09:55:50

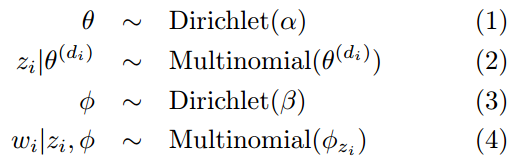

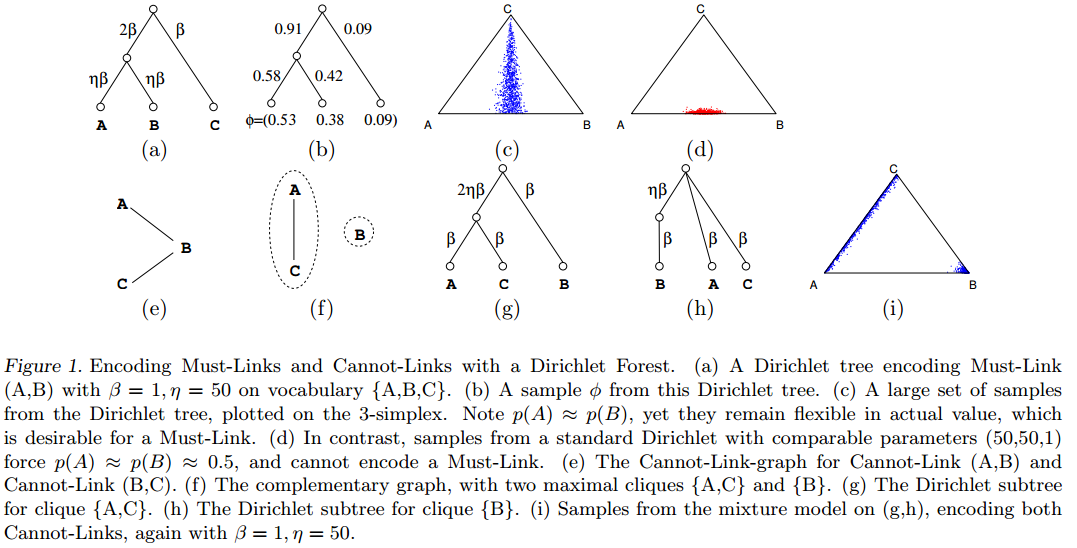

[TOC] 领域知识可以提升LDA的效果。这篇文章应该是最早将领域知识引入到LDA模型中的。作者首先提出了很多的领域知识都可以用二元词组来表示,即must-links和cannot-links(很容易理解,就是哪些单词属于一个主题,哪些单词不属于一个主题)。然后作者将这种领域知识当做Dirichlet森林先验(Dirichlet Forest Prior),用来替换主题词分布p(word|topic)的Dirichlet先验。Dirichlet Forest先验是一个混合的Dirichlet树分布,具有很多特的树结构。作者的方法有很多优点:1)Dirichlet Forest Prior可以把must-links和cannot-links引入到LDA模型中,而传统的Dirichlet模型却不行。2)用户可以通过设置参数$eta$来控制先验的影响力。3)Dirichlet Forest先验很容易使用Gibbs抽样求解参数。 传统的LDA模型的生成过程如下:  作者改进的步骤主要是第三步。作者的第三步是: ```math q \sim \text{DirichletForest}(\beta,\eta) ``` ```math \phi \sim \text{DirichletTree}(\textbf{q}) ``` 在这里,q是一个Dirichlet树分布,$\beta$是类似LDA里面主题-词分布的超参数,$\eta \geq 1$时候控制领域知识强度的“强度参数”。作者首先描述如何用Must-links和Cannot-links来表示领域知识。 Must-links和Cannot-links最早是提出来用于作为聚类的限制条件的,它倾向于将两个实例分到相同的簇中,或者是分到不同的簇中。作者将相关的概念引入到话题模型中。 #####Must-links的编码 我们都知道Dirichlet分布有一个限制是所有的单词除了具有相同的正规化约束外都共享一个方差参数,但却相互独立。但是,Must-link(u,v)要求把这两个单词放到一起。与其他的不同。于是作者采用了DirichletTree分布来解决这个问题。Dirichlet Tree Distribution是一颗具有特殊结构的树,其叶子节点是单词。如图1中的(a)图所示。其中$\gamma^{(k)}$是Dirichlet树的指向$k$节点的边的权重,$C(k)$是节点$k$的直接子节点,$L$是树的叶子节点,$I$是树的内部节点,$L(k)$是连接到k节点的叶子节点。为了从DirichletTree中生成一个样本,$\phi \sim \text{DirichletTree}(\gamma)$,首先我们需要在每个内部节点$s \in I$处,从$\text{Dirichlet}(\gamma^{C(s)})$抽取一个多项式(其参数是$s$节点指向其子节点的权重)。我们可以把这个过程当做是通过这个多项式来对到达$s$的概率进行重抽样。那么,每个单词$k \in L$的概率$\phi(k)$就是$k$节点到根节点所有的边的权重的乘积。如图1中的(b)所示。于是我们有: ```math \text{DirichletTree}(\gamma) \equiv = p(\phi|\gamma) = (\prod_{k}^{L}\phi^{(k)^{\gamma^{(k)}-1}})(\prod_{s}^{I}\frac{\Gamma(\sum_{k}^{C(s)}\gamma^{(k)})}{\prod_{k}^{C(s)}\Gamma(\gamma^{(k)})}(\sum_{k}^{L(s)}\phi^{(k)})^{\Delta^{(s)}}) ``` 在这里,$\Delta(s) \equiv \gamma^{(s)}-\sum\_{k\in C(s)}\gamma^{(k)}$,也就是内部节点$s$的入度和出度之间的差,当二者之间的差为零的时候,DirichletTree分布就变成了Dirichlet分布了。  与Dirichlet分布一样,DirichletTree分布也是多项式分布的共轭分布。所以我们可以直接将$\phi$积分掉,从单词数量中直接得到一个分布,和多元Polya Distribution类似,我们有: ```math p(\textbf{w}|\gamma)=\prod_{s}^{I}(\frac{\Gamma(\sum_{k}^{C(s)}\gamma^{(k)})}{\Gamma(\sum_{k}^{C(s)}(\gamma^{(k)}+n^{(k)})} \prod_{k}^{C(s)} \frac{\Gamma(r^{(k)}+n^{(k)})}{\Gamma(\gamma^{(k)})}) ``` 这里,$n^{(k)}$是$L(k)$中w单词出现的次数。 作者将Must-links当做是一个Dirichlet Tree。作者定义的Must-link是具有传递性的,也就是说 (u,v)和(v,w)是两个must-link,那么(u,w)也是一个must-link。作者将每一个传递闭包(transitive closure)都当做是一个子树,它包括一个内部节点,其中的单词都是它的叶子节点。这个内部节点到叶子节点的权重是$\eta \beta$。根节点和这些所有的内部节点$s$相连,权重是$|L(s)|\beta$,这里的$|\cdot|$代表集合的大小。 让我们理解一下这个Must-links的编码,首先考虑领域知识的强度最弱的情况,也就是$\eta=1$的时候。这时候Dirichlet Tree就变成了一个Dirichlet分布。那么Must-Links就没有起到作用了。当我们增大$\eta$的时候,内部节点$s$处的抽样就要变化了,它就集中在$|L(s)|\eta \beta$处,但是基分布依然一样。这时候他就倾向于在$s$的传递闭包中均匀抽样。由于$s$处的质量与$\eta$相互独立,因此它仍然具有较大的方差。这个性质正好是我们希望Must-links可以比较相似,但不能总是以较大的概率被抽样。否则的话must-links的单词将会在所有的话题中都会以较大的概率出现。以图1中的(c)和(d)为例。我们用三维的单纯概率来展示,A、B、C三个点的概率之后必须是1,而他们本身的概率在[0,1]之间(因为我们从Dirichlet分布中抽取的是一个分布,它是多项式分布的先验,就像是我们从一大袋筛子中抽取一个筛子的结果)。三角形上的任意一点在三维空间的坐标之和都是1,他们对应的x、y和z轴的坐标分别是A、B和C三点的概率。图1中的(c)和(d)都是从图1(a)中的大规模抽样结果。其中,(c)是从Dirichlet树中抽取的结果,我们可以看到,$P(A) \approx P(B)$,而这两个点的概率之和确实从0到1各个地方都有。与此最像的Dirichlet分布是参数为(50,50,1)的Dirichlet分布,我们可以看到,抽取的大部分样本都是在(0.5,0.5,0)附近的结果。显然从DirichletTree分布中抽取的结果更符合预期。 ##### Cannot-Links编码 与Must-links相比,Cannot-links的编码更加难以处理。作者首先将Cannot-links的编码转换成类似的Dirichlet Tree。注意Cannot-links是不具有传递性的。作者定义Cannot-Link-Graph为节点是单词,边是Cannot-Links。当我们对Cannot-Links编码时,这个联通的图之间是相互独立的,之后作者利用了这个性质来分解Dirichlet-tree的选择概率。如图1的(e)所示,两个Cannot-links为(A,B)和(B,C),它是带有一个联通部分的结果{A,B,C}。考虑联通部分的子图r。作者定义了一个补图的概念,即把原来的边去掉,把没有边的节点用边连接。假设$Q^{(r)}$是这个补图的最大团。在图1的例子中,$Q^{(r)}=1$,$M\_{r1}={A,C}$,$M\_{r2}={B}$。这些团有如下的解释:每个团都是联通部分的最大的单词子集,并非常有可能在一起出现。也就是说这些单词允许以较大的概率同时出现在一个话题中,但却没有破坏Cannot-Links的约束。通过最大化这些团,使得任意团外的节点都有可能以一个较大的概率破坏Cannot-Link。

赏

支付宝扫码打赏

如果文章对您有帮助,欢迎打赏鼓励作者

Back to Top