加载中...

加载中...

MLPerf™是MLCommons发布的一个用来测试AI相关软硬件性能的基准测试工具。2021年12月1日, Training v1.1的结果发布,这个结果不仅展示了最新的AI相关软硬件的进展,也有一个新的现象,就是AI训练正在超越摩尔定律。本文将简要解读一下相关数据。

MLCommons是由多家企业与高校联合成立的一个组织,为的是推动机器学习的创新进步。为此,他们试图通过三个领域的开放写作来满足新生的行业需求,即基准测试、数据集和最佳实践。

包括Google、Nvidia、Intel、AMD等都是其创始单位。国内的百度、阿里、地平线也是其创始会员之一。

MLPerf™是MLCommons最有名的测试,它的主要目的是提供一个大家认同的任务测试基准,让各家单位使用自己的软硬件来对相关任务的模型进行训练,以获取当前AI软硬件性能的基准情况。MLPerf™测试包括训练、推理、HPC等。本文主要为大家解释最新发布的训练的1.1版本的结果。

MLPerf™的训练测试包括两种,一个是封闭测试,一个是开放测试。封闭测试需要参与单位提供自己的硬件和系统环境,用来测试相同的基准模型的训练时间。而开放测试则允许各家提交自己的模型。

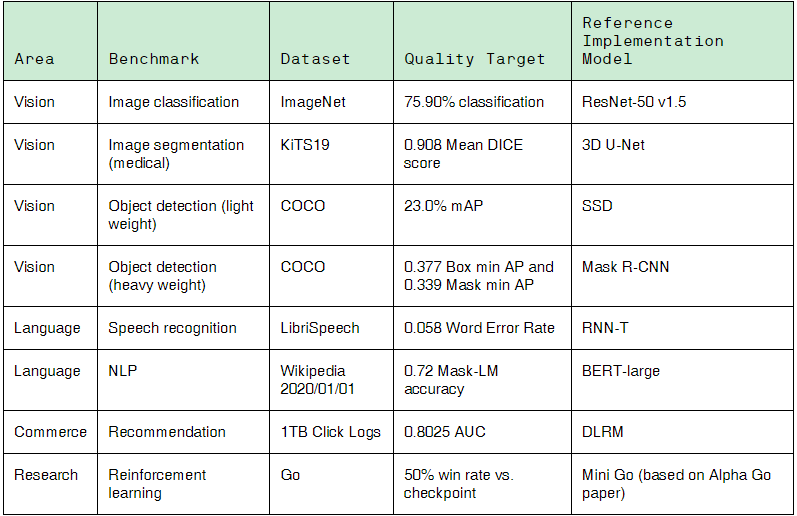

目前,封闭测试的任务包括8个:4个视觉模型、2个语言模型、1个商业模型和1个研究模型。具体任务如下:

可以看到,封闭式测试里面已经定义好了数据集、模型、目标等,需要各家提供自己的运行环境,用以测试模型的训练速度。

每个基准测量在指定数据集上训练模型以达到指定质量目标所需的训练时间。去除最高和最低结果,取剩余测试的平均值来说明最终的结果。

最新一轮的基准测试收到了来自14个组织的提交材料,并发布了超过185个经同行评审的机器学习系统的结果,范围从边缘设备到数据中心服务器。本轮提交的资料包括来自Azure、百度、戴尔、富士通、技嘉、谷歌、Graphcore、HabanaLabs、HPE、Inspur、联想、英伟达、三星和Supermicro的软件和硬件创新。

由于这个结果比较多,我们不一一列举,大家感兴趣可以去MLPerf v1.1 Results看结果。我们举几个例子。

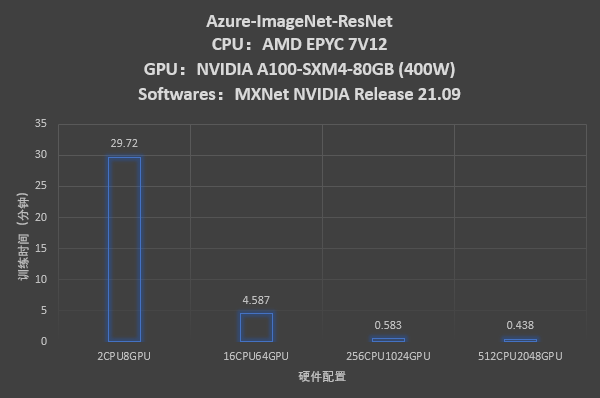

第一个是微软云平台对ImageNet数据集的图像分类的测试结果。

可以看到,如果使用2个CPU和8个GPU训练的话,需要29.72分钟。增加硬件可以显著降低训练时间。但是从256个CPU1024个GPU增加到512个CPU和2048个GPU训练时间降低却很少了。所以,这里其实应该有个权衡的。

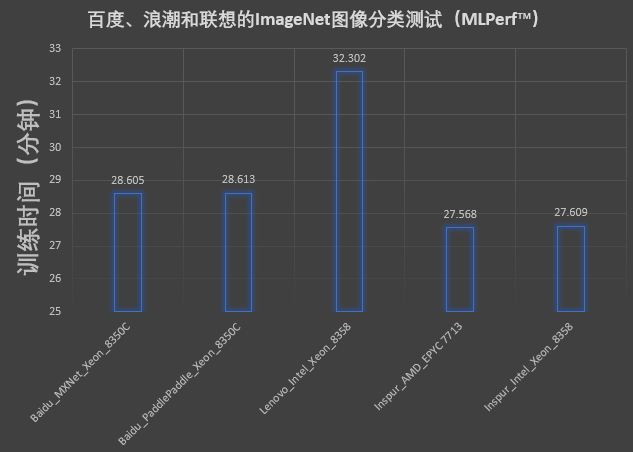

第二个我们关注一下国产厂商。这一次测试,国产厂商中百度、浪潮和联想参与了测试。我们也是看一下这个ImageNet数据集的图像分类的测试结果。

这里选取的都是2个CPU和8个GPU的测试结果。GPU大家都是Nvidia的A100,但是版本略有差异,CPU都是因特尔的,但是大家都不一样。测试结果看,百度和浪潮的28秒左右都是很好的成绩。联想这个水平的确有点差距,虽然总体不差,但是这么看还是不太行。

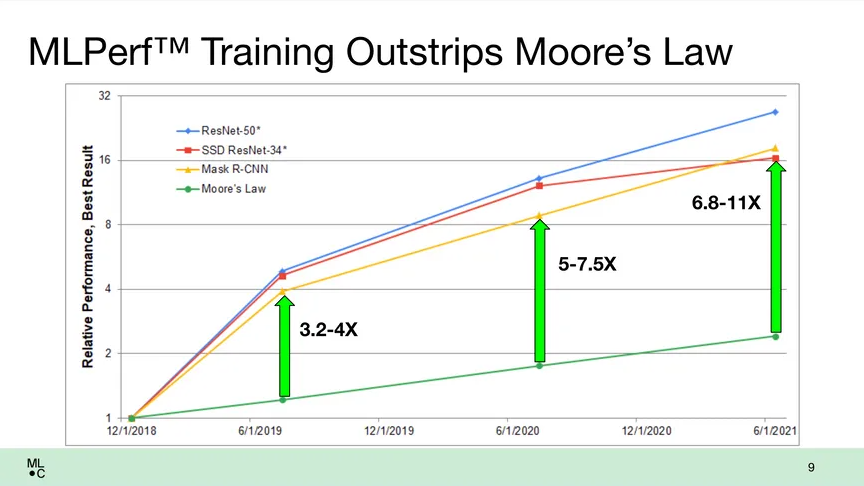

最后总结一下,由于有了MLPerf™这种基准的测试,大家很容易能看到这几年的发展。下图是MLCommons给出的,我们可以惊讶的发现AI的训练正在超越摩尔定律。

晶体管密度的增加将导致早期版本的MLPerf基准和2021年6月的基准之间的性能增加一倍多一点。但是,软件以及处理器和计算机架构的改进为最佳基准测试结果带来了6.8-11倍的速度提升。在最新的测试中,就是现在的这个1.1的测试,最佳结果比6月的测试结果提高了2.3倍。

据Nvidia称,在过去18个月中,使用A100 GPU的系统性能提高了5倍多,自三年前首次推出MLPerf基准测试以来提高了20倍。

哎~不得不感叹,时代进步太快了。在目前的AI时代,硬件和软件架构的更新使得AI相关算法的效率提升太快了。