Unifying Language Learning Paradigms——谷歌的一个模型打天下

如今,自然语言处理的预训练模型被广泛运用在各个领域。各大企业和组织都在追求各种大型的预训练模型。但是当你问我们应该使用哪一个预训练模型来解决问题的时候,通常没有统一的答案,一般来说它取决于下游的任务,也就是说需要根据任务类型来选择模型。

而谷歌认为这不是一个正确的方向,因此,本周,谷歌提出了一个新的NLP预训练模型框架——Unifying Language Learning Paradigms(简称UL2)来尝试使用一个模型解决多种任务。

通用模型的吸引力是显而易见的。首先,我们可以专注一个模型来提升模型的水平,不需要关注多个分散的模型。此外,在资源有限的情况下,只有少数模型可以提供服务(例如,在设备上),最好是有一个单一的预训练模型,可以在许多类型的任务上表现良好。

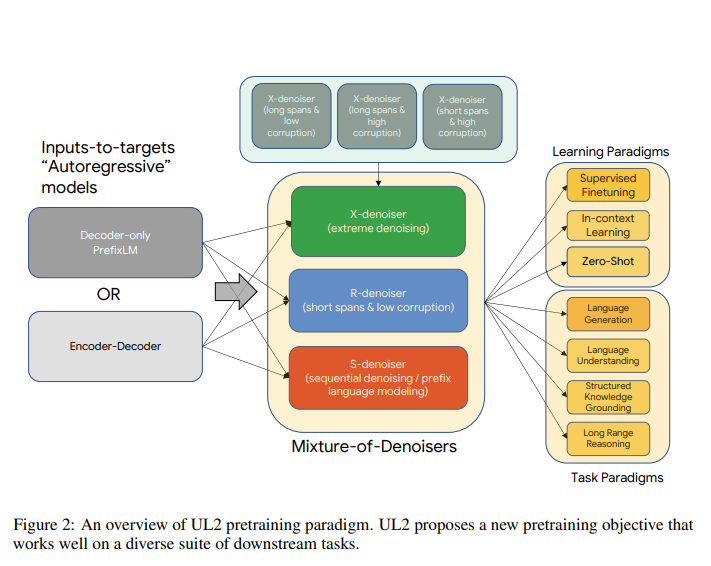

上图就是这个UL2模型的框架。谷歌的研究人员猜想,一个强大的通用模型必须在预训练期间接触到解决不同的问题集。鉴于预训练是通过self-supervision完成的,这种多样性应该被注入到模型的目标中,否则模型可能会缺乏某种能力,比如长连贯的文本生成。受此启发,以及当前的目标函数类别,作者定义了在预训练中使用的三个主要范式:

R-Denoiser--常规去噪是Raffel等人(2019)介绍的标准span corruption,它使用2到5个标记的范围作为跨度长度,这掩盖了大约15%的输入标记。这些跨度很短,对获取知识而不是学习生成流畅的文本有潜在的作用。