重磅!学术论文处理预训练大模型GALACTICA发布!

自然语言处理预训练大模型在最近几年十分流行,如OpenAI的GPT-3模型,在很多领域都取得了十分优异的性能。谷歌的PaLM也在很多自然语言处理模型中获得了很好的效果。而昨天,PapersWithCode发布了一个学术论文处理领域预训练大模型GALACTICA。功能十分强大,是科研人员的好福利!

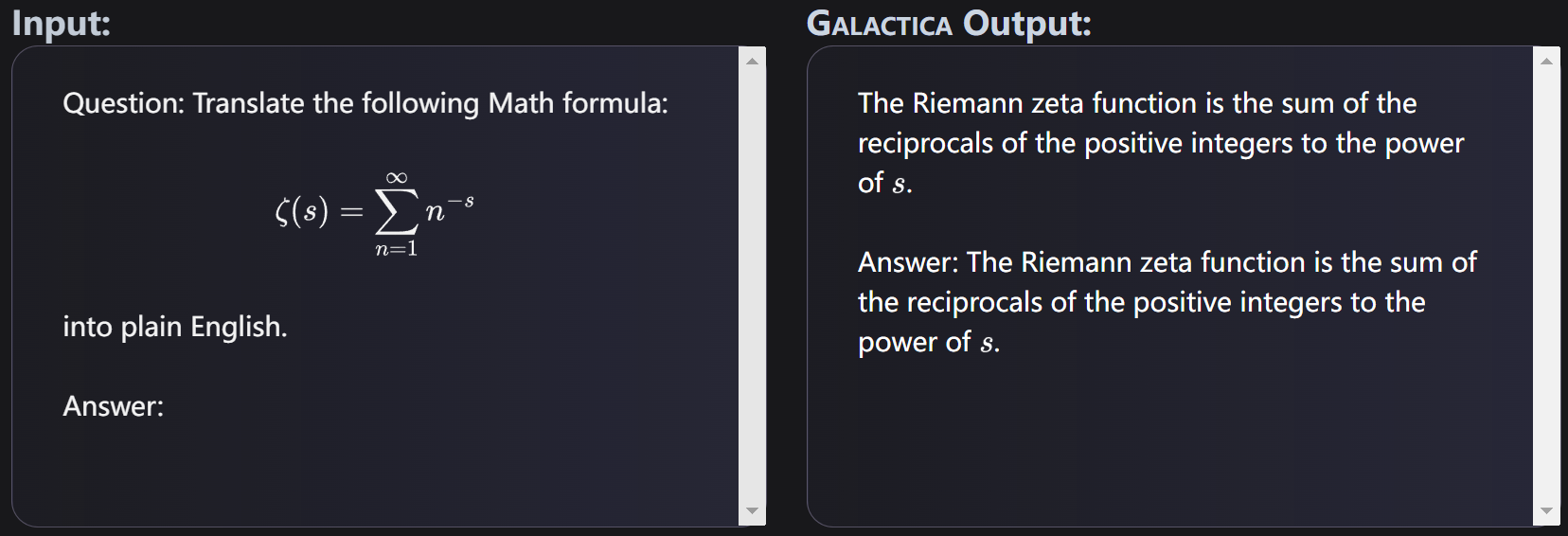

GALACTICA可以总结学术文献,解决数学问题,生成Wiki文章,编写科学代码,对分子和蛋白质进行注释等等。

信息过载是科学进步的一个主要障碍。科学文献和数据的爆炸性增长使得在大量的信息中发现有用的见解变得越来越难。今天,人们通过搜索引擎来获取科学知识,但它们却无法单独组织科学知识。PapersWithCode发布的Galactica是一个可以存储、组合和推理科学知识的大型语言模型。在一个由论文、参考资料、知识库和许多其他来源组成的大型科学语料库上进行训练。该模型在一系列科学任务上的表现超过了现有模型。在诸如LaTeX方程式的技术知识探测上,Galactica比最新的GPT-3高出68.2%和49.0%。Galactica在推理方面也表现良好,在数学MMLU上比Chinchilla高出41.3%对35.7%,在MATH上比PaLM 540B高出20.4%对8.8%。它还在PubMedQA和MedMCQA dev等下游任务上创下了77.6%和52.9%的最新水平。尽管没有经过一般语料库的训练,Galactica在BIG-bench上的表现超过了BLOOM和OPT-175B。

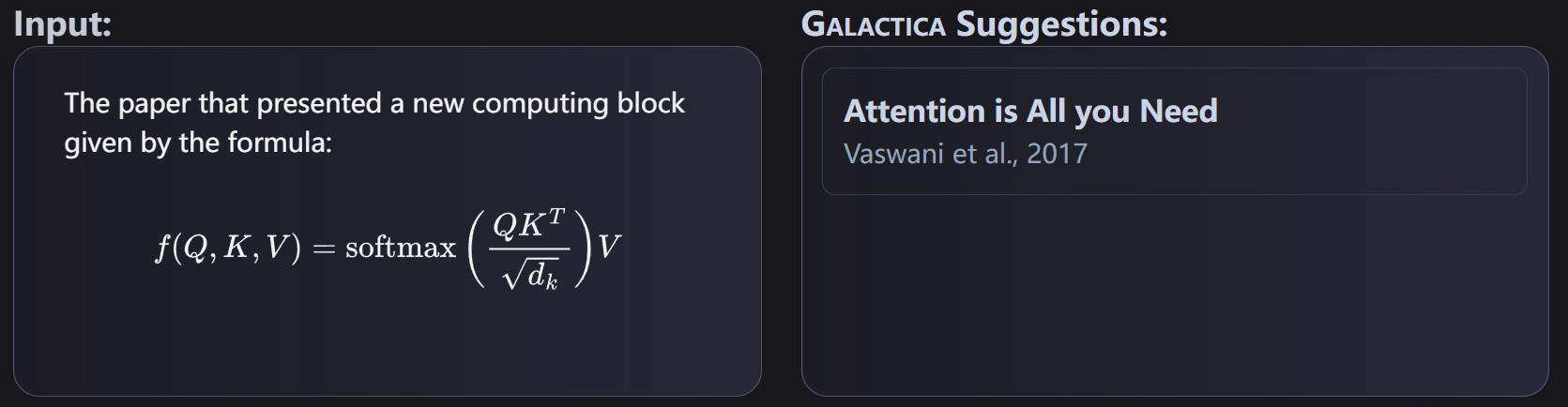

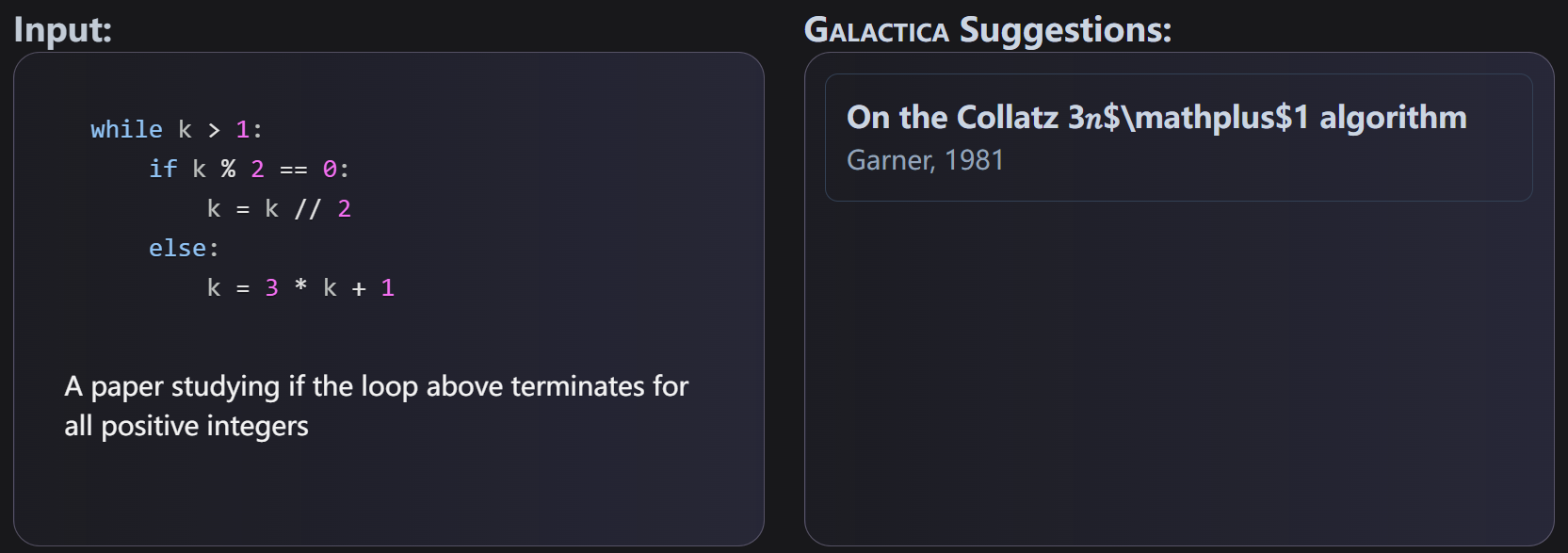

GALACTICA是可以处理很多任务。举例如下: