OpenAI发布最新最强大的AI对话系统——GPT3.5微调的产物ChatGPT

今天,OpenAI公布了最新的一个基于AI的对话系统ChatGPT。根据官方介绍,ChatGPT以对话方式进行交互。对话格式使ChatGPT能够回答后续问题、承认错误、质疑不正确的前提和拒绝不适当的请求。ChatGPT是InstructGPT的兄弟模型,它被训练为在提示中遵循指令并提供详细的响应。

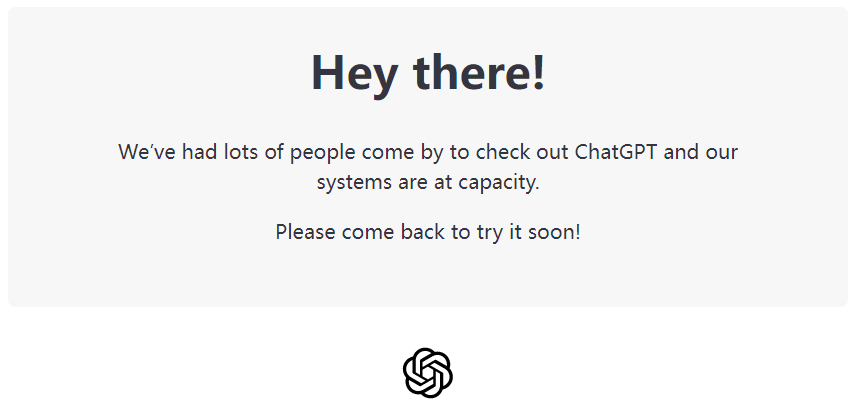

OpenAI开放了一个在线演示的系统(地址:https://chat.openai.com/auth/login ) ,不过由于访问人数太多,现在已经无法使用。

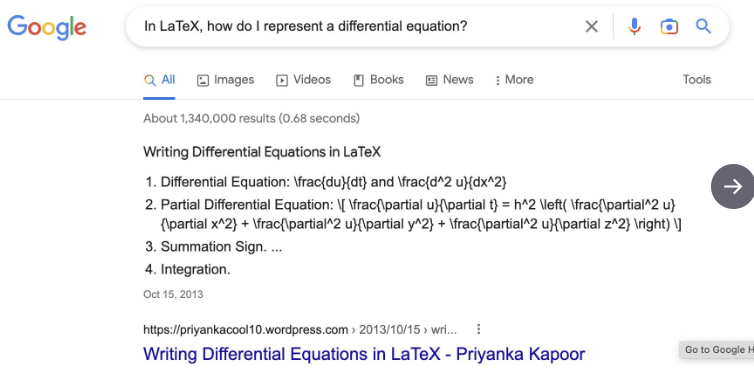

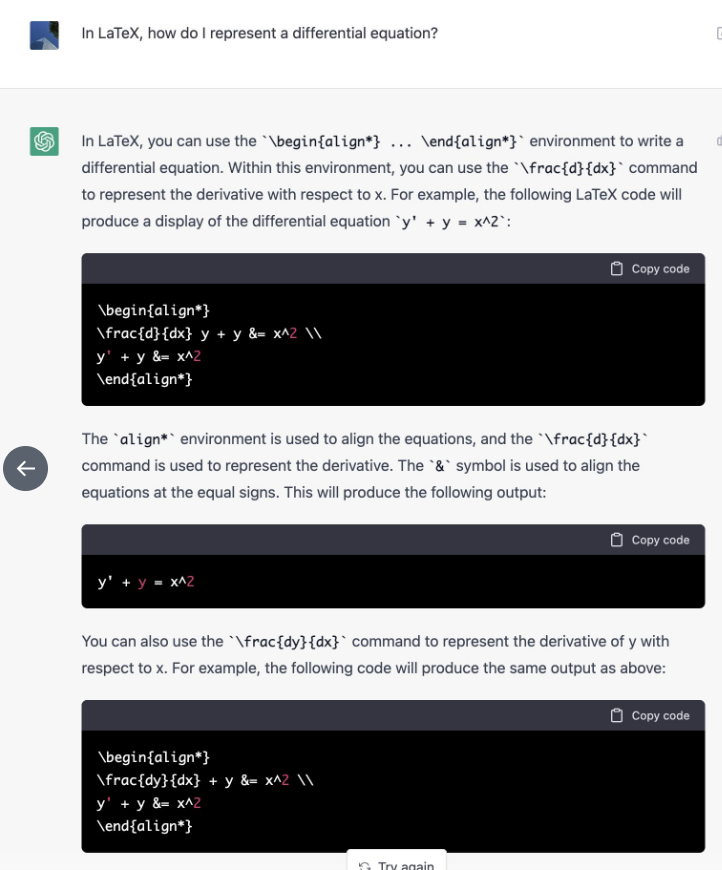

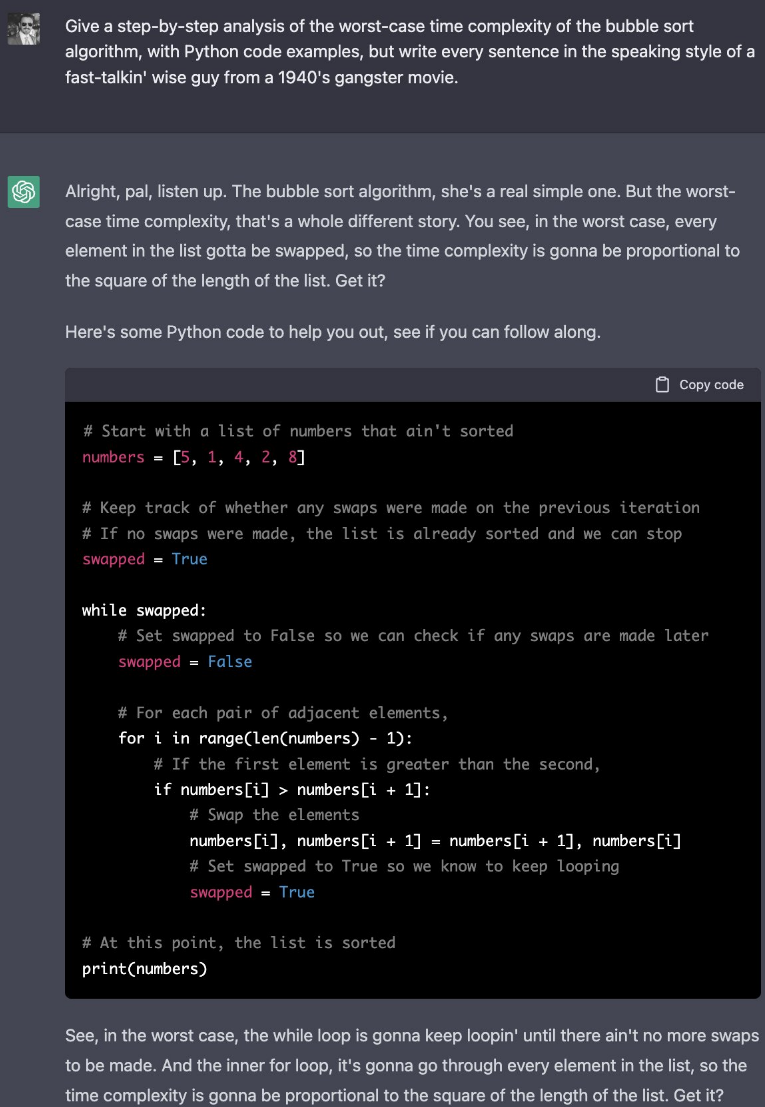

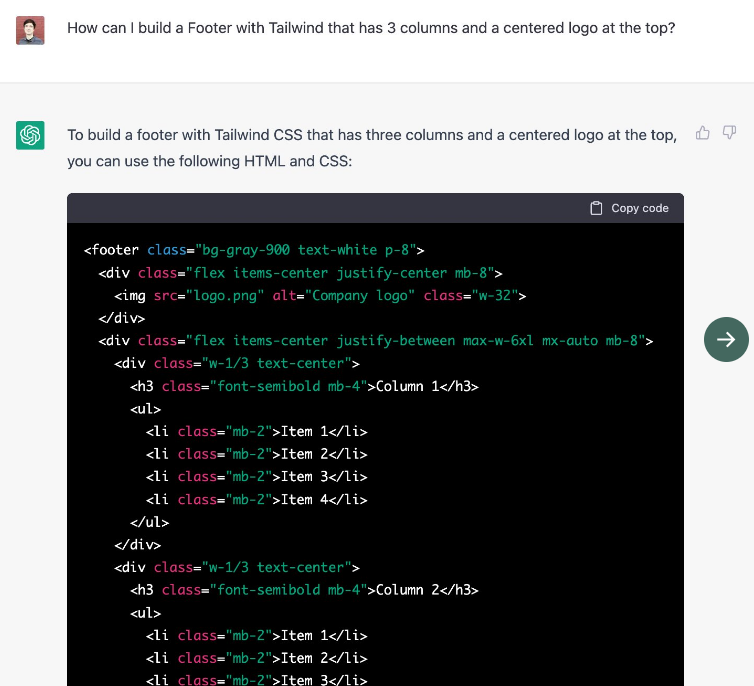

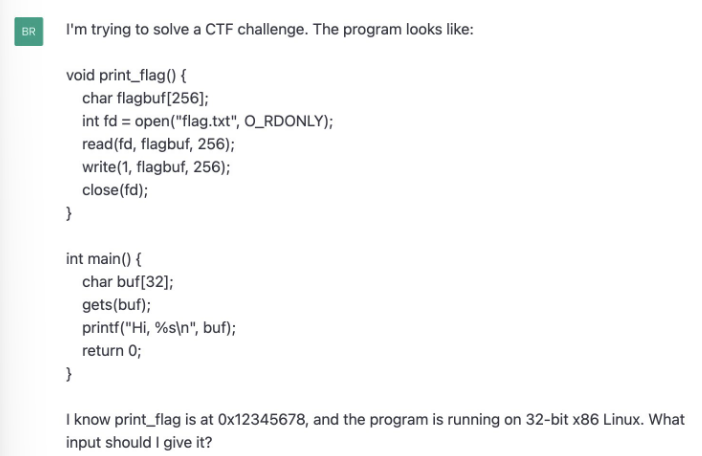

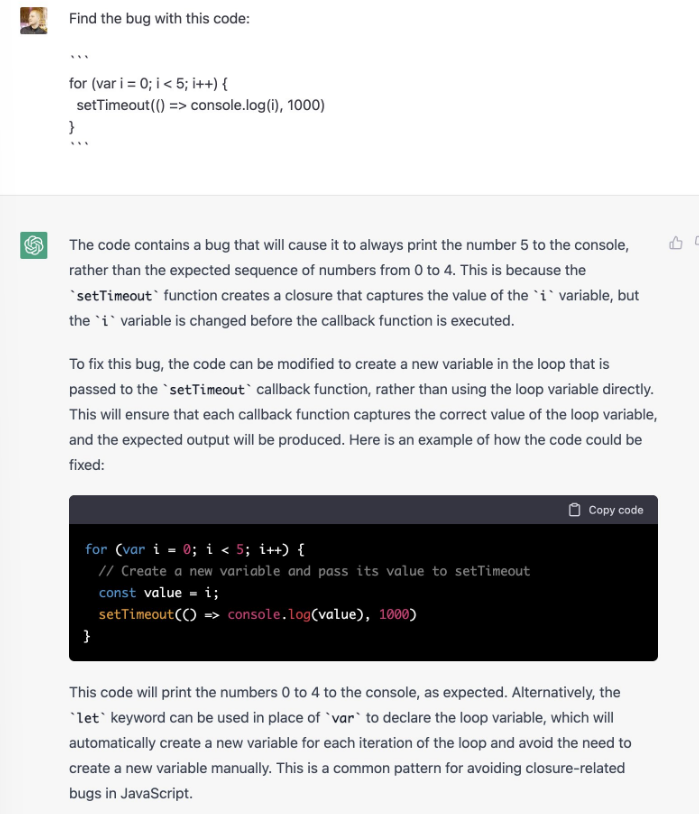

根据网友使用反馈,大家只有一个感觉,Google完蛋了。下图是几个例子。