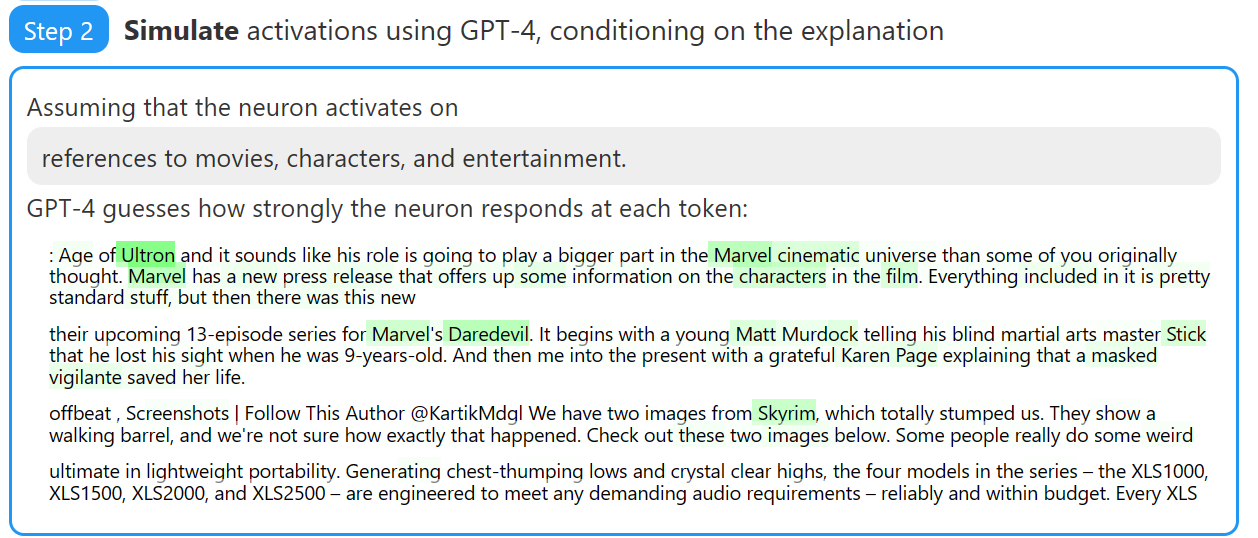

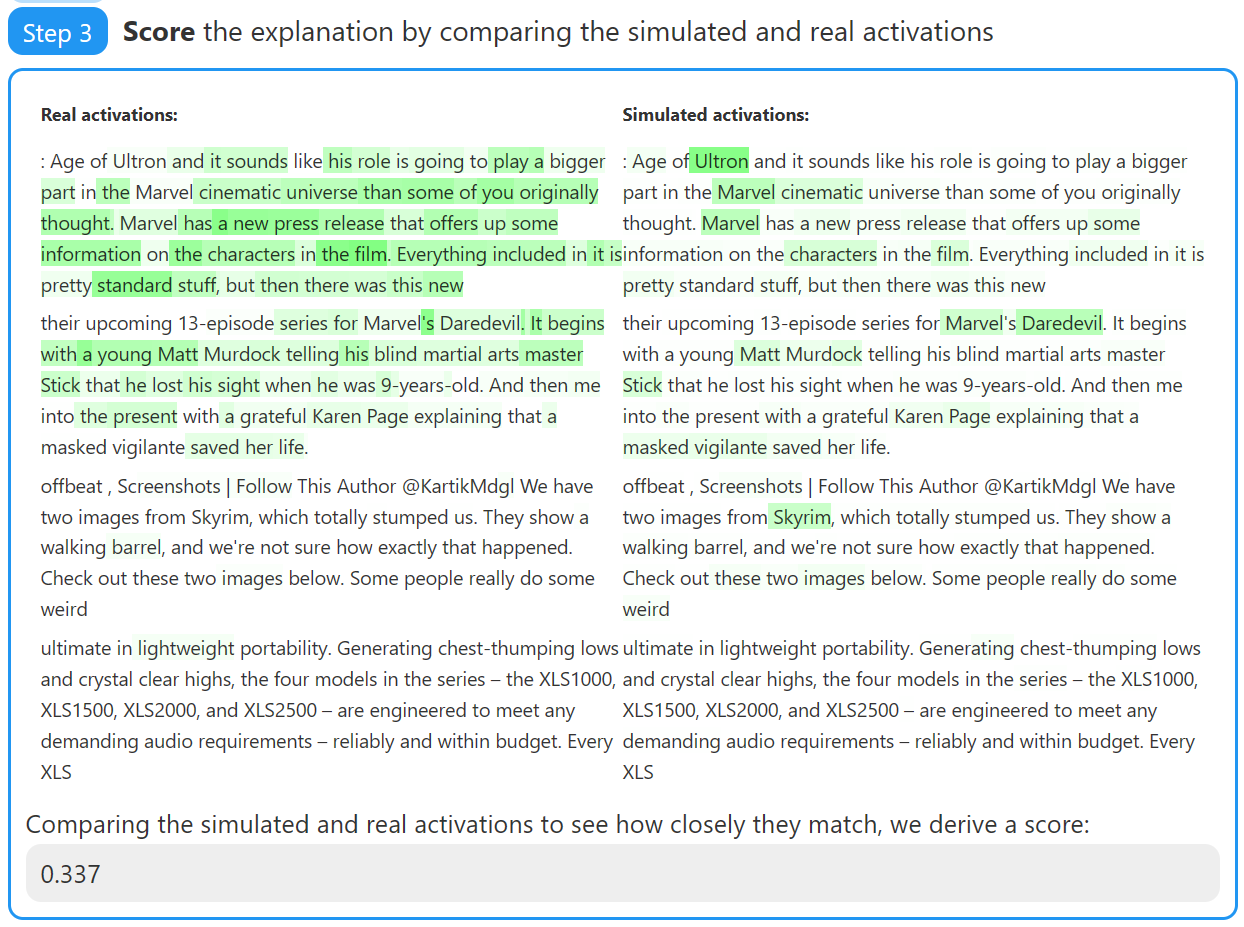

OpenAI官方最新研究成果:如何用GPT-4这样的语言模型来解释语言模型中的神经元(neurons)

尽管像GPT-4这样的语言模型已经展示了强大的能力,但是,基于transformer这种深度学习架构的语言模型依然缺乏足够的可解释性。例如,从输出的结果来看,我们依然很难检测模型中是否使用了biased heuristics或者engage in deception。

今天,OpenAI官方宣布了一个非常有意思的论文,他们使用GPT-4模型来自动解释GPT-2中每个神经元的含义,试图让语言模型来对语言模型本身的原理进行解释。