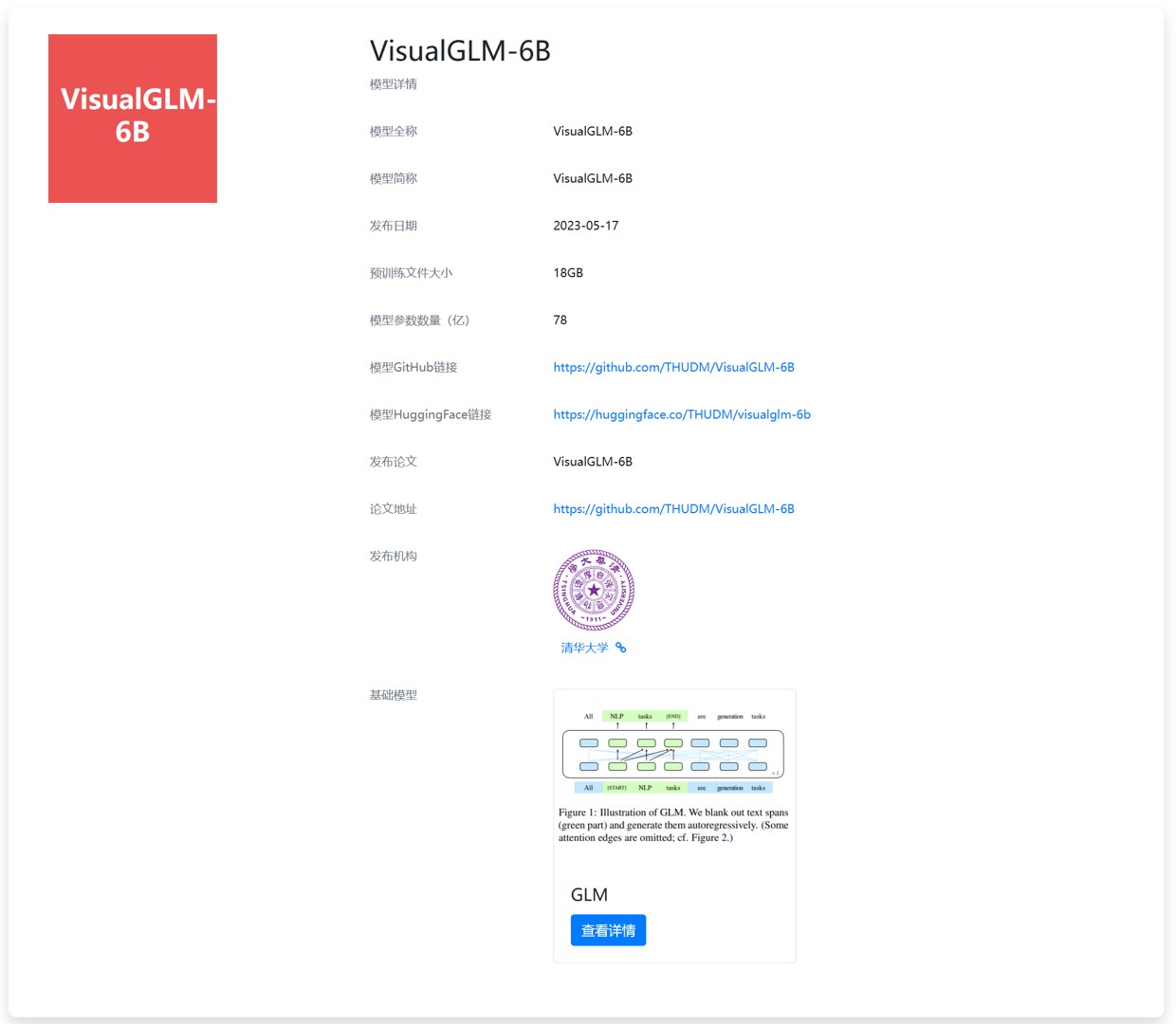

ChatGLM-6B升级!清华大学开源VisualGLM-6B:一个可以在本地运行的读懂图片的语言模型!

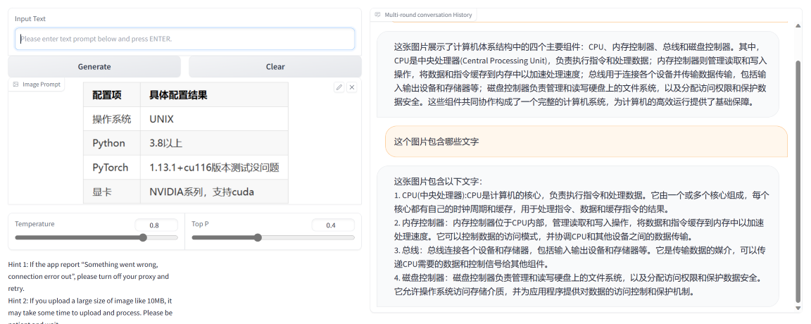

ChatGLM-6B是清华大学知识工程和数据挖掘小组(Knowledge Engineering Group (KEG) & Data Mining at Tsinghua University)发布的一个开源的对话机器人。因其良好的性能和较低的部署成本,在国内受到了广泛的关注和好评。今天,THUDM开源了ChatGLM-6B的多模态升级版模型VisualGLM-6B。这是一个多模态对话语言模型,支持图像、中文和英文。

VisualGLM-6B在DataLearner模型卡的信息:https://www.datalearner.com/ai-models/pretrained-models/VisualGLM-6B