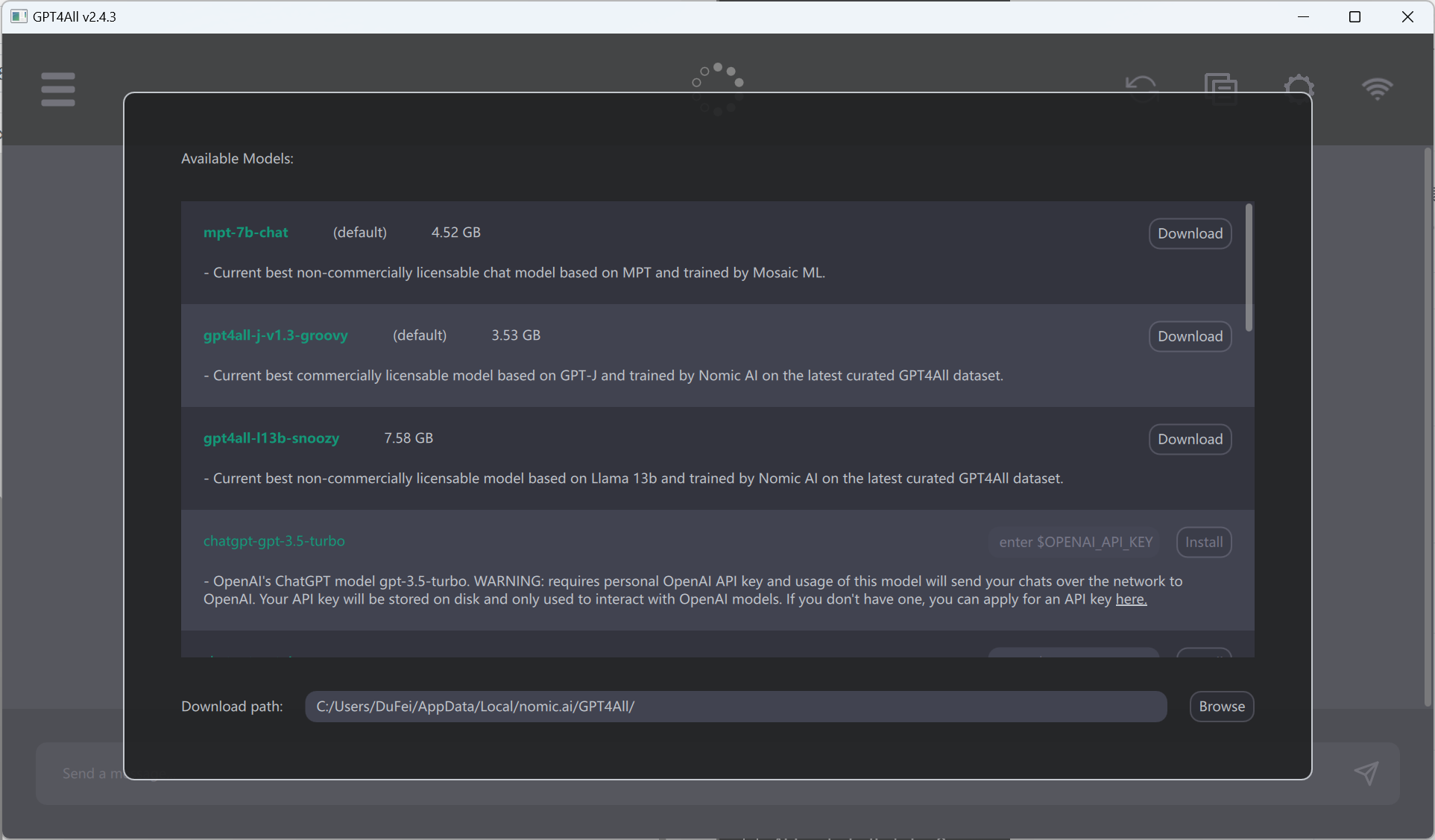

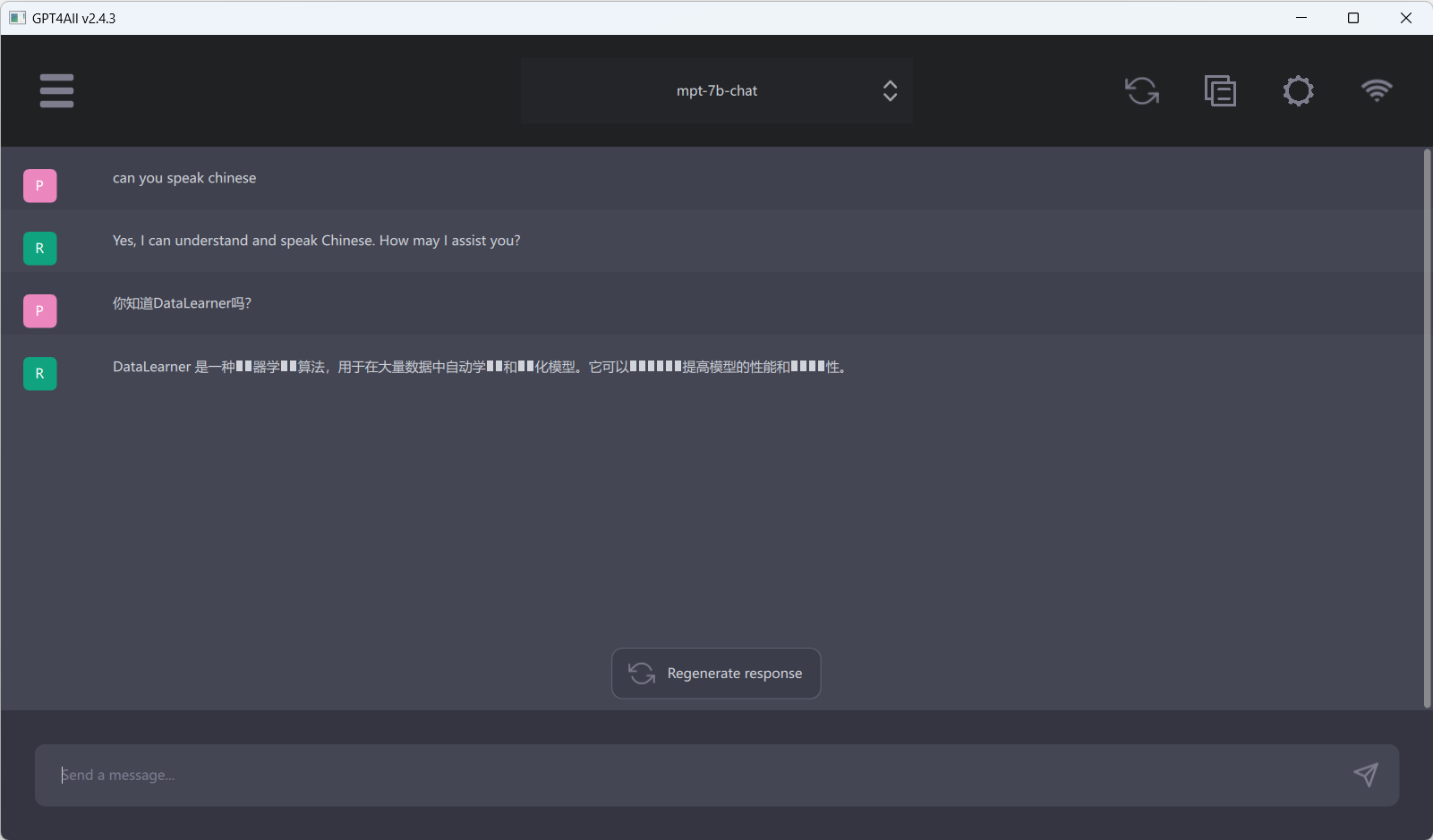

GPT4All:一个可以直接在本地运行各大商业友好的开源大模型解决方案

----------------2023年7月15日GPT4All增加支持embedding能力---------------- 2023年7月15日,NomicAI官方宣布最新版的GPT4All支持embedding模型,只需要1G内存即可运行: https://www.datalearner.com/blog/1051684590410303

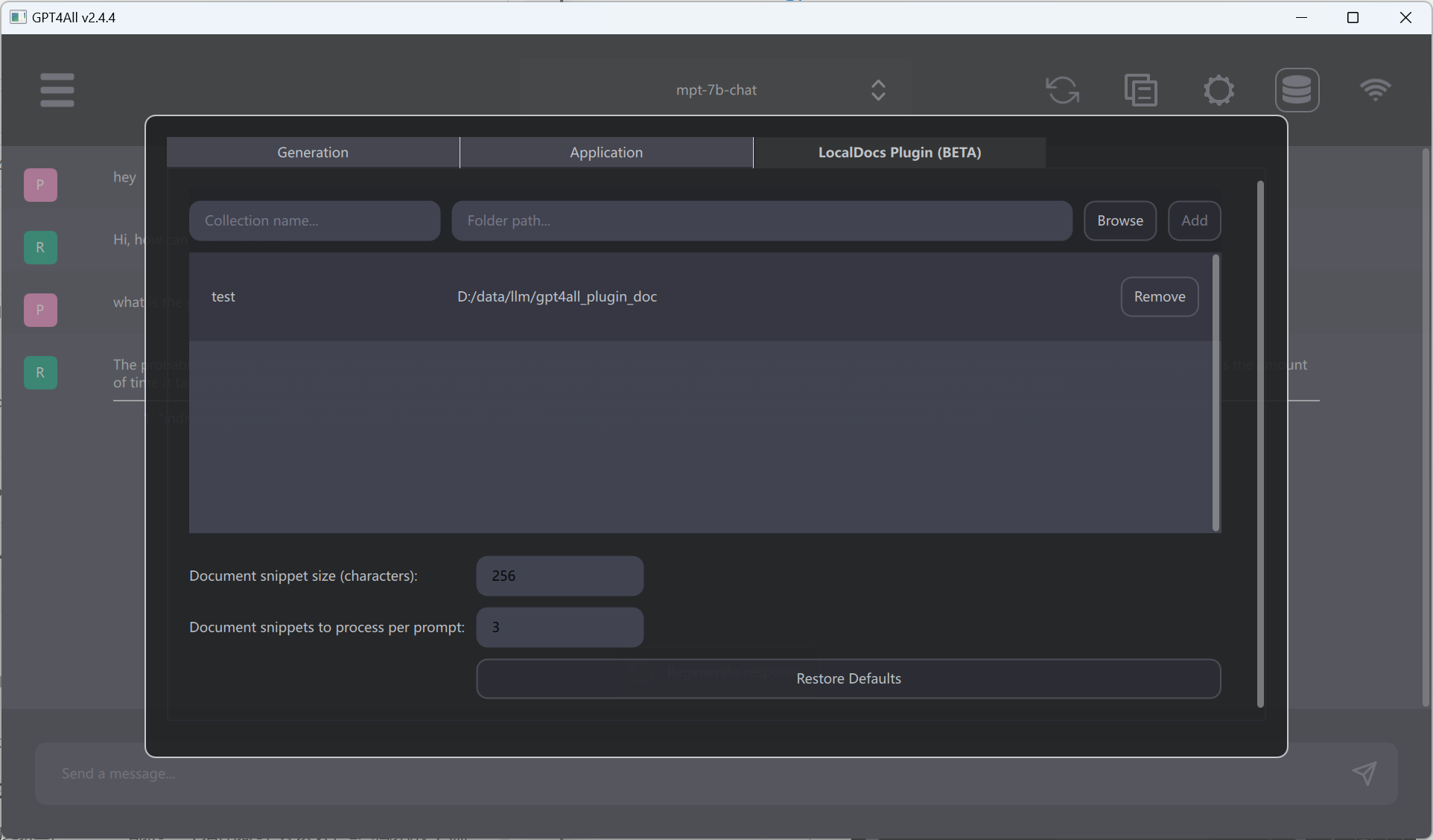

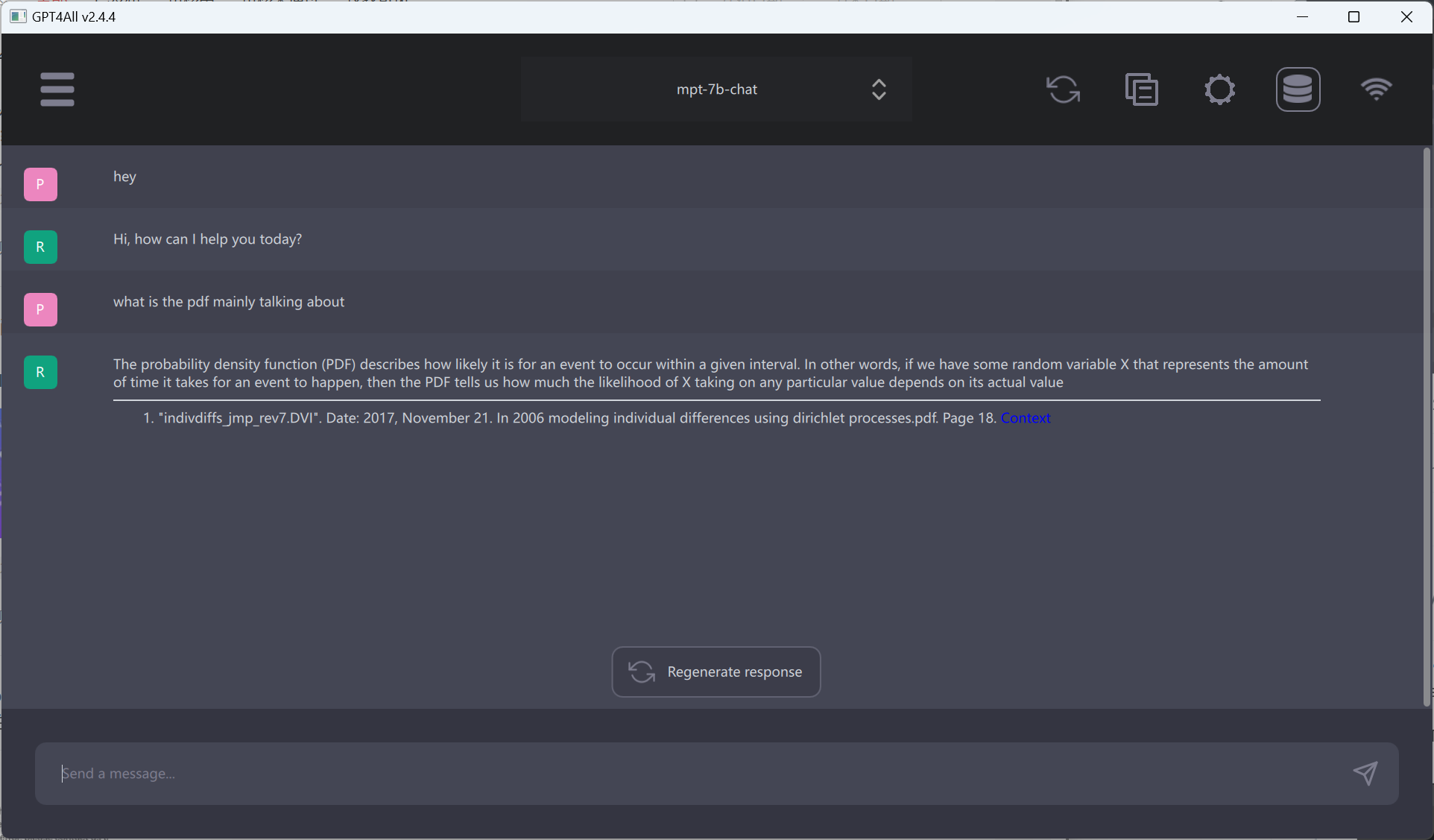

**-------------------2023年6月1日GPT4All更新支持读取本地文档----------------------- ** 2023年6月1日,NomicAI官方宣布最新版的GPT4All支持加载本地文档,然后根据本地文档读取内容,使用不同的大模型来针对这个文档进行问答! **-------------------2023年6月1日GPT4All更新支持读取本地文档----------------------- **

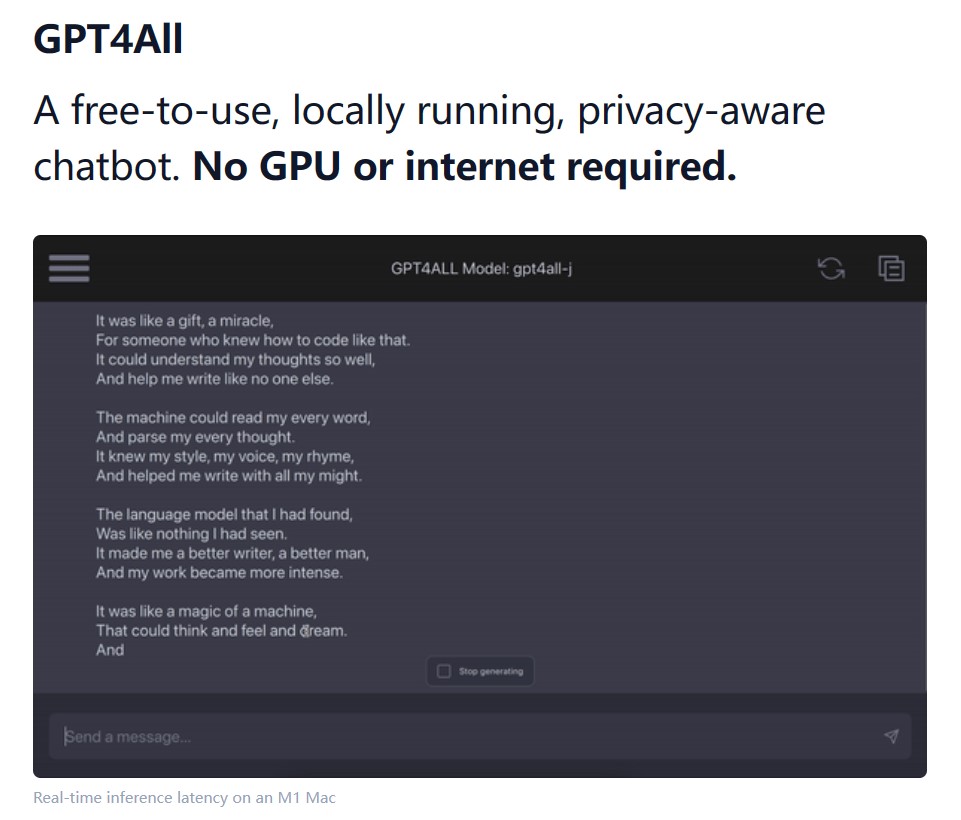

大型语言模型如GPT-4,Google Bard等正在引领新一轮的技术革新。这些模型在许多任务中都表现出强大的性能,包括文本生成,情感分析,文本理解等。然而,使用这些大型语言模型往往需要联网访问,依赖于强大的GPU计算能力,且成本高昂,这给普通用户和小型开发团队带来了巨大的挑战。