分类和Logistic回归

预测连续值(如房价),可以通过线性回归zhongd中的线性函数来做,只要设定输入值(如房子大小)即可,但是有时候,我们希望去预测一个离散的变量,比如说预测一个栅格像素密度是否表示成数字 “0”或者“1”,此时,线性回归的效果就显得非常差了。现在,我们将会聚焦二元分类(binary classification)问题,其中y仅取值0或者1。举例来看,如果我们想要尝试建立一个垃圾邮件分类器,那么x(i)表示邮件的一系列特征,y=1则表示这是一篇垃圾邮件,y=0则反之,这里的1表示积极反馈(positive class),0表示消极反馈(negative class),它们有时候也被表示成“+”或者“-”。

###Logistic regression

在线性回归中,我们通常用线性函数y=hθ(x)预测x(i)的y(i),然而这不能解决预测二元分类标签(y(i)∈{0,1})的问题。当我们知道y∈{0,1}时,hθ(x)的取值比1大或者比0小则显得没有任何意义。

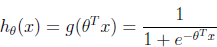

于是,我们将假设h(x)的形式表示如下: 其中:,被称作logistic函数或者sigmoid函数,其函数图像如下: 当z→∞时,g(z)→1;当z→-∞时,g(z)→0。所以g(z)和h(x)都是在(0,1)区间内的,这样就可以将其作为概率值使用了。当然,如果还有其他的均匀从0增加到1的函数,也可以被用的。但是,当我们在讨论GLMs和一般性的学习算法时,logistic函数的选择是相当自然的。 再继续说明之前,先介绍下logistic函数的导数表示: