大语言模型的技术总结系列一:RNN与Transformer架构的区别以及为什么Transformer更好

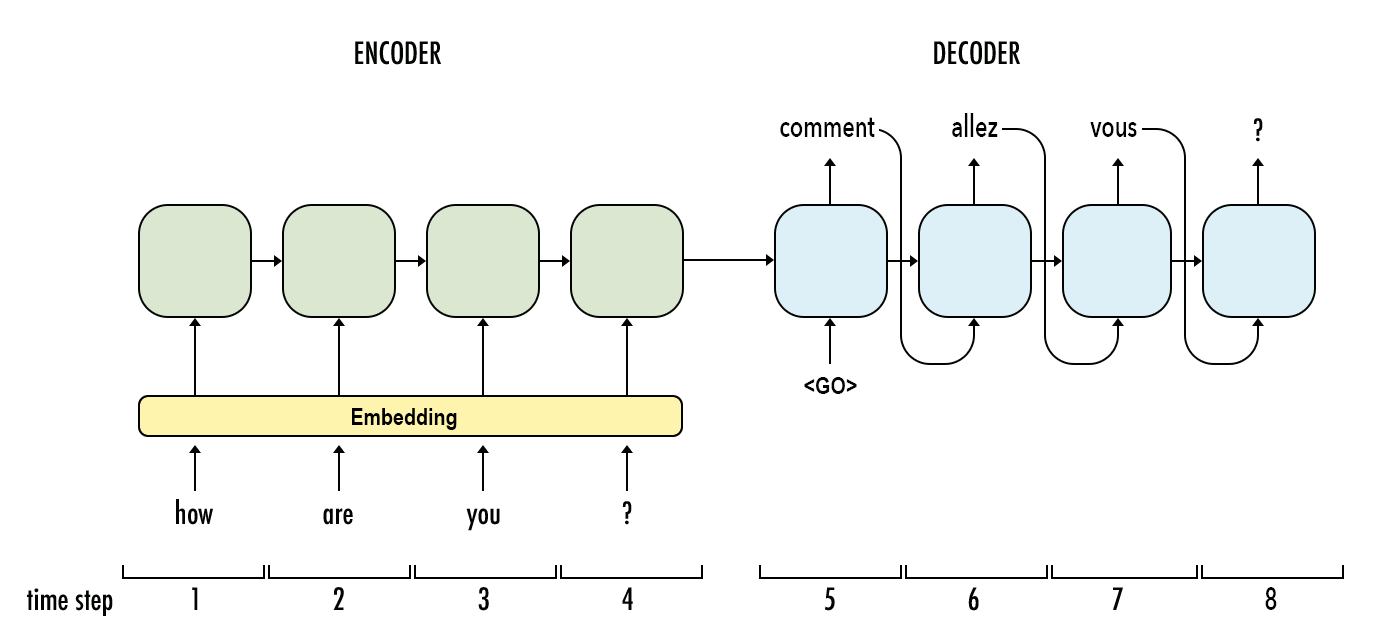

大语言模型(Large Language Model,LLM)是近几年进展最大的AI模型。早期的深度学习架构语言模型以RNN为主,现在则基本上转成了Transformer的架构。尽管如此,Transformer本身也是有着不同的区别。本文是大语言模型技术系列中的一篇,主要介绍RNN模型与Transformer之间的区别。

需要注意的是,如果想彻底弄清楚RNN和Transformer的底层技术原理需要大家看懂它们的公式,而本文主要的目的是尽量在不涉及公式的前提下说清楚二者的区别。对于RNN本身的介绍以及Transformer结构的介绍不多,核心是说清楚二者的区别。因此,需要如果大家对RNN和Transformer有一点基本的了解,应该看起来很容易。