生成式AI平台的玩家都有哪些?

近几年人工智能的发展已经让大家感受到AI算法不再是实验室的小玩具,它对社会和生活的影响已经在逐步显现。仅几年的AI模型如ChatGPT、DALL·E2、StableDiffusion等都是生成式模型,即基于无标注数据训练的可以根据输入观测数据的模型。而生成式AI平台可能是未来最重要的一种平台能力。本文是由Matt Bornstein, Guido Appenzeller, and Martin Casado等人发布的介绍当前生成式AI平台的相关企业。

加载中...

近几年人工智能的发展已经让大家感受到AI算法不再是实验室的小玩具,它对社会和生活的影响已经在逐步显现。仅几年的AI模型如ChatGPT、DALL·E2、StableDiffusion等都是生成式模型,即基于无标注数据训练的可以根据输入观测数据的模型。而生成式AI平台可能是未来最重要的一种平台能力。本文是由Matt Bornstein, Guido Appenzeller, and Martin Casado等人发布的介绍当前生成式AI平台的相关企业。

欢迎关注 DataLearner 官方微信,获得最新 AI 技术推送

我们开始看到生成性人工智能(AI)的技术栈出现的早期阶段。数以百计的新创业公司正急于进入市场,开发基础模型,建立人工智能原生应用程序,并建立基础设施/工具。

许多热门技术趋势在市场跟上之前就被过度炒作了。但是,生成性人工智能的繁荣已经伴随着真实市场的真实收益,以及来自真实公司的真实牵引力。像Stable Diffusion和ChatGPT这样的模型正在创造用户增长的历史记录,一些应用在推出后不到一年就达到了1亿美元的年化收入。并排比较显示,人工智能模型在一些任务中的表现要比人类好几个数量级。

因此,有足够的早期数据表明,大规模转型正在发生。我们不知道的是,现在已经成为关键问题的是。在这个市场中,哪些地方会产生价值?

在过去的一年里,我们会见了几十位直接处理生成性人工智能的创业公司创始人和大公司的经营者。我们观察到,到目前为止,基础设施供应商可能是这个市场上最大的赢家,获得了流经该堆栈的大部分资金。应用公司的收入增长非常快,但往往在保留、产品差异化和毛利率方面挣扎。而大多数模型供应商,虽然对这个市场的存在负有责任,但还没有达到大规模的商业规模。

换句话说,创造最大价值的公司--即训练生成性人工智能模型并将其应用于新的应用程序--还没有抓住其中的大部分。预测接下来会发生什么就更难了。但我们认为,关键是要了解堆栈的哪些部分是真正的差异化和可防御的。这将对市场结构(即横向与纵向的公司发展)和长期价值的驱动力(如利润率和保留率)产生重大影响。到目前为止,我们很难在堆栈的任何地方找到结构上的可防御性,除了传统的现有公司的护城河。

我们非常看好生成性人工智能,并相信它将对软件行业和其他行业产生巨大影响。这篇文章的目的是描绘出市场的动态,并开始回答关于生成性人工智能商业模式的更广泛的问题。

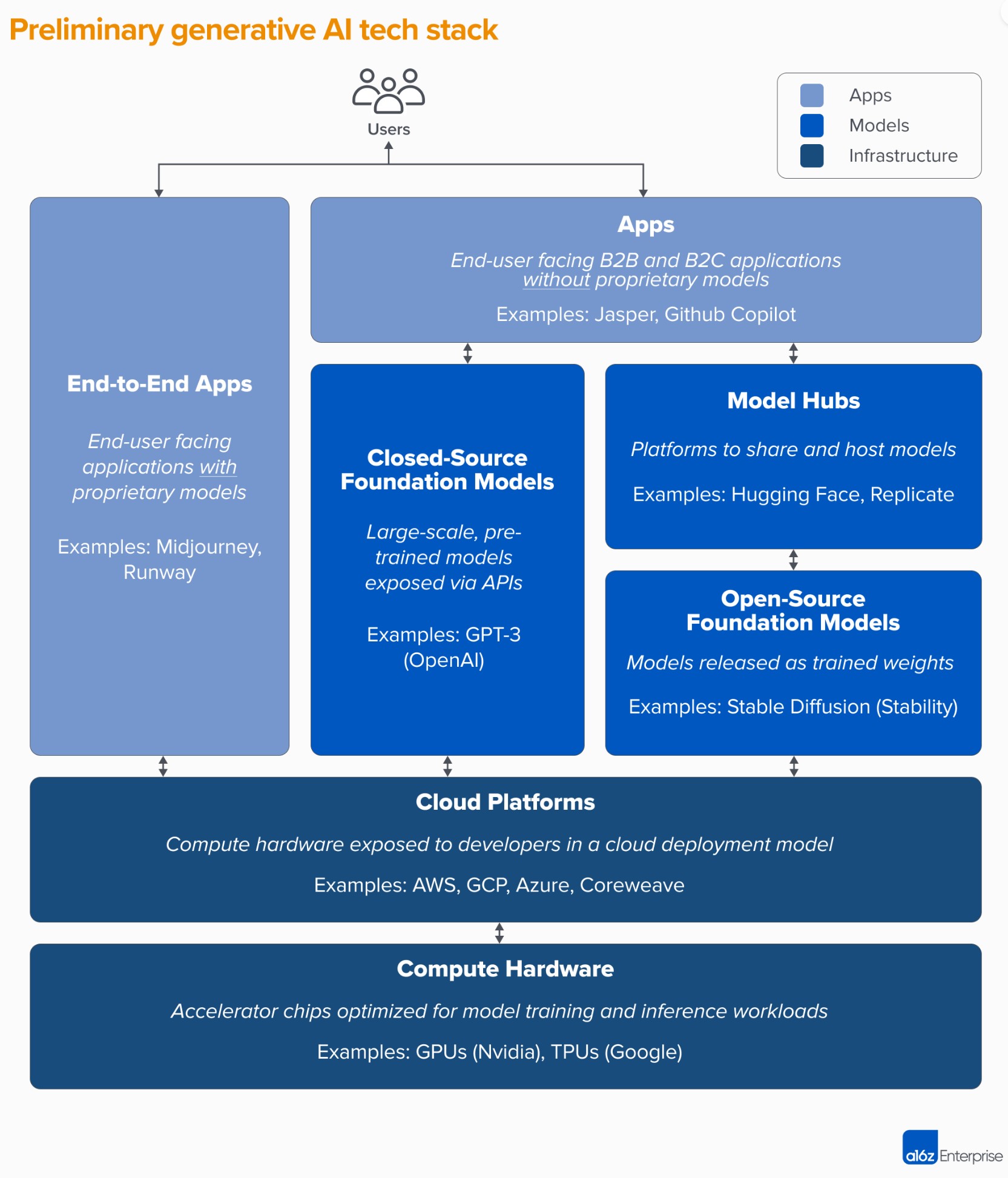

高水平的技术栈:基础设施、模型和应用程序

为了了解生成性人工智能市场是如何形成的,我们首先需要定义今天的堆栈是什么样的。以下是我们的初步看法。

该堆栈可分为三层:

需要注意的是:这不是一个市场地图,而是一个分析市场的框架。在每个类别中,我们已经列出了一些知名厂商的例子。我们没有试图做到全面,也没有列出所有已经发布的惊人的生成性人工智能应用。我们在这里也没有深入探讨MLops或LLMops工具,这还没有高度标准化,将在未来的文章中讨论。

第一波生成性人工智能应用开始达到规模,但在保留和差异化方面却很困难.

在以前的技术周期中,传统的智慧是,要建立一个大型的、独立的公司,你必须拥有终端客户--无论这意味着个人消费者还是B2B买家。很容易让人相信,生成性人工智能中最大的公司也将是终端用户的应用。到目前为止,还不清楚情况是这样的。

可以肯定的是,生成性人工智能应用的增长是惊人的,由纯粹的新颖性和大量的使用案例所推动。事实上,我们知道至少有三个产品类别的年收入已经超过了1亿美元:图像生成、文案写作和代码编写。

然而,光是增长还不足以建立持久的软件公司。最关键的是,增长必须是有利可图的--在这个意义上,用户和客户一旦注册,就会产生利润(高毛利)并长期存在(高保留率)。在没有强大的技术差异化的情况下,B2B和B2C应用程序通过网络效应,保留数据,或建立越来越复杂的工作流程来推动长期的客户价值。

在生成性人工智能中,这些假设不一定成立。在与我们交谈过的应用程序公司中,毛利率的范围很广--在少数情况下高达90%,但更多时候低至50-60%,主要由模型推理的成本驱动。渠道顶端的增长是惊人的,但目前的客户获取策略是否可以扩展还不清楚--我们已经看到付费获取的效率和保留率开始下降。许多应用程序也相对缺乏差异性,因为它们依赖于类似的底层人工智能模型,并没有发现明显的网络效应,或数据/工作流程,而竞争对手很难复制。

因此,目前还不明显,销售终端用户应用程序是建立可持续的生成性人工智能业务的唯一,甚至是最好的途径。随着语言模型的竞争和效率的提高,利润率应该会提高(下面会有更多介绍)。随着人工智能游客离开市场,保留率应该增加。而且有一个强有力的论点是,垂直整合的应用程序在推动差异化方面具有优势。但仍有很多东西需要证明。

展望未来,生成型AI应用公司面临的一些大问题包括:

模型供应商发明了生成式人工智能,但还没有达到大型商业规模。

如果没有谷歌、OpenAI和Stability等公司的杰出研究和工程工作,我们现在所说的生成性人工智能就不会存在。通过新颖的模型架构和扩展训练管道的英勇努力,我们都受益于当前大型语言模型(LLMs)和图像生成模型的令人震惊的能力。

然而,与这些公司相关的收入与使用量和热闹程度相比仍然相对较小。在图像生成方面,稳定扩散公司在用户界面、托管产品和微调方法的生态系统支持下,看到了社区的爆炸性增长。但稳定公司将他们的主要检查点免费赠送,这是他们业务的核心宗旨。在自然语言模型方面,OpenAI以GPT-3/3.5和ChatGPT为主导。但到目前为止,基于OpenAI构建的杀手级应用相对较少,而且价格已经下降了一次。

这可能只是一个暂时的现象。稳定性是一家新公司,还没有把重点放在货币化上。OpenAI有可能成为一个庞大的业务,随着更多的杀手级应用的建立,它可以赚取所有NLP类别收入的很大一部分--特别是如果它们与微软的产品组合的整合顺利进行。鉴于这些模型的巨大使用量,大规模的收入可能离我们不远了。

但也有反作用力。作为开源发布的模型可以由任何人托管,包括不承担大规模模型培训相关费用(高达数千或数亿美元)的外部公司。而且目前还不清楚是否有任何闭源模型能够无限期地保持其优势。例如,我们开始看到Anthropic、Cohere和Character.ai等公司建立的LLMs更接近OpenAI的性能水平,它们在类似的数据集(即互联网)上训练,并采用类似的模型架构。稳定扩散的例子表明,如果开源模型的性能和社区支持达到了足够的水平,那么专有的替代品可能会发现难以竞争。

到目前为止,对模型提供者来说,最明显的收获也许是商业化可能与托管有关。对专有API的需求(例如来自OpenAI)正在迅速增长。开源模型的托管服务(如Hugging Face和Replicate)正在出现,成为方便分享和整合模型的有用枢纽--甚至在模型生产者和消费者之间产生一些间接的网络效应。还有一个强烈的假设是,有可能通过微调和与企业客户的托管协议来实现盈利。

不过,除此之外,模型供应商还面临着一些大问题:

基础设施供应商触及一切,并获得了回报。

生成式人工智能中的几乎所有东西都会在某些时候经过云托管的GPU(或TPU)。无论是模型供应商/研究实验室运行训练工作负载,托管公司运行推理/微调,还是应用公司进行两者的某种组合--FLOPS是生成式人工智能的命脉。在很长一段时间里,最具有颠覆性的计算技术的进展第一次受到大规模计算的约束。

因此,生成性人工智能市场的很多资金最终都流向了基础设施公司。用一些非常粗略的数字来表示。我们估计,平均而言,应用程序公司在推理和每个客户的微调上花费了大约20-40%的收入。这通常是直接支付给云供应商的计算实例或第三方模型供应商--他们反过来又将大约一半的收入用于云基础设施。因此,我们有理由猜测,今天生成性人工智能总收入的10-20%是给了云供应商。

除此之外,训练自己的模型的初创公司已经筹集了数十亿美元的风险投资--其中大部分(在早期回合中高达80-90%)通常也用于云供应商。许多公共科技公司每年在模型培训上花费数亿美元,要么与外部云供应商合作,要么直接与硬件制造商合作。

用技术术语来说,这就是我们所说的 "大量的钱"--尤其是对于一个新生的市场。其中大部分是花在三大云上。亚马逊网络服务(AWS)、谷歌云平台(GCP)和微软Azure。这些云供应商每年总共花费超过1000亿美元的资本支出,以确保他们拥有最全面、最可靠和最具成本竞争力的平台。特别是在生成性人工智能方面,他们也受益于供应限制,因为他们可以优先获得稀缺的硬件(如Nvidia A100和H100 GPU)。

但有趣的是,我们开始看到可信的竞争出现了。像甲骨文这样的挑战者已经通过大笔的资本支出和销售奖励取得了进展。一些初创公司,如Coreweave和Lambda Labs,已经通过专门针对大型模型开发商的解决方案迅速成长。他们在成本、可用性和个性化的支持方面进行竞争。他们还公开了更多的细化资源抽象(即容器),而大型云由于GPU虚拟化的限制,只提供虚拟机实例。

在幕后,运行绝大部分人工智能工作负载的,也许是迄今为止生成性人工智能的最大赢家。Nvidia。该公司在2023财年第三季度报告了38亿美元的数据中心GPU收入,其中有相当一部分用于生成性人工智能的使用案例。他们通过几十年来对GPU架构的投资,强大的软件生态系统,以及在学术界的深入应用,已经围绕这一业务建立了强大的护城河。最近的一项分析发现,Nvidia的GPU在研究论文中被引用的次数是顶级AI芯片初创公司的90倍。

其他硬件选择确实存在,包括谷歌张量处理单元(TPU);AMD Instinct GPU;AWS Inferentia和Trainium芯片;以及Cerebras、Sambanova和Graphcore等初创公司的AI加速器。英特尔在游戏中姗姗来迟,也在以他们的高端Habana芯片和Ponte Vecchio GPU进入市场。但到目前为止,这些新芯片中很少有占据重要市场份额的。两个值得关注的例外是谷歌和台积电,前者的TPU已经在稳定扩散社区和一些大型GCP交易中获得牵引力,后者被认为制造了这里列出的所有芯片,包括Nvidia GPU(英特尔使用自己的工厂和台积电混合制造其芯片)。

换句话说,基础设施是一个有利可图的、持久的、似乎可以防御的堆栈层。基础设施公司需要回答的大问题包括:

当然,我们还不知道。但根据我们对生成性人工智能的早期数据,结合我们对早期人工智能/ML公司的经验,我们的直觉是这样的。

今天,在生成性人工智能中似乎没有任何系统性的护城河。作为一个一阶近似值,应用程序缺乏强大的产品差异化,因为它们使用类似的模型;模型面临不明确的长期差异化,因为它们是在类似的数据集和类似的架构上训练的;云供应商缺乏深刻的技术差异化,因为它们运行相同的GPU;甚至硬件公司在相同的工厂生产他们的芯片。

当然,还有标准的护城河:规模护城河("我有或可以比你筹集更多的资金!"),供应链护城河("我有GPU,你没有!"),生态系统护城河("每个人都已经在使用我的软件!"),算法护城河("我们比你更聪明!"),分销护城河("我已经有一个销售团队和比你多的客户!")和数据管道护城河("我爬过的互联网比你多!")。但这些护城河都不可能长期持久。而且,现在判断强大的、直接的网络效应是否在堆栈的任何一层中占据优势还为时尚早。

根据现有的数据,目前还不清楚在生成性人工智能领域是否会出现长期的、赢家通吃的动态。

这很奇怪。但对我们来说,这是个好消息。这个市场的潜在规模难以把握--介于所有软件和所有人类努力之间--因此我们预计会有很多、很多的参与者,并在堆栈的各个层面进行健康的竞争。我们也期望横向和纵向的公司都能成功,最好的方法是由终端市场和最终用户决定的。例如,如果终端产品的主要差异化是人工智能本身,那么垂直化(即把面向用户的应用程序与本土模型紧密结合)很可能会胜出。而如果人工智能是一个更大的、长尾的功能集的一部分,那么就更有可能发生横向化。当然,随着时间的推移,我们也应该看到更多传统的护城河的建立--我们甚至可能看到新类型的护城河占据上风。

无论怎样,我们可以肯定的一点是,生成性人工智能改变了游戏。我们都在实时学习规则,有大量的价值将被释放出来,而科技景观将因此而显得非常、非常不同。而我们正为此而努力

本文来自Matt Bornstein, Guido Appenzeller, and Martin Casado等人的博客《Who Owns the Generative AI Platform?》的翻译。 原文地址:https://a16z.com/2023/01/19/who-owns-the-generative-ai-platform/