2022年必读的AI论文——100个AI领域被引最多的论文分析

尽管AI领域在工业界发展迅速,企业研究机构在拼命的开发相关的产品以推动各自业务的发展。但是他们也在科研领域不断贡献大量的AI论文。Zeta Alpha的一篇博客分析了2022年发表的被引用最多的100篇AI论文,给大家提供一个洞察思路。

其实本次分析包含了过去三年的数据,即2020、2021和2022年每年的引用最多的100篇AI领域论文。从发表机构和地区角度分析。

先说主要结论:

- 美国的企业和高校的论文影响力第一,中国第二

- 清华大学在高影响力论文占比中靠前,也是唯一国内上榜机构

- 如果按照有影响力论文与所有论文比例看,国内没有机构上榜

目录如下:

一、按照国家和地区角度看论文数量

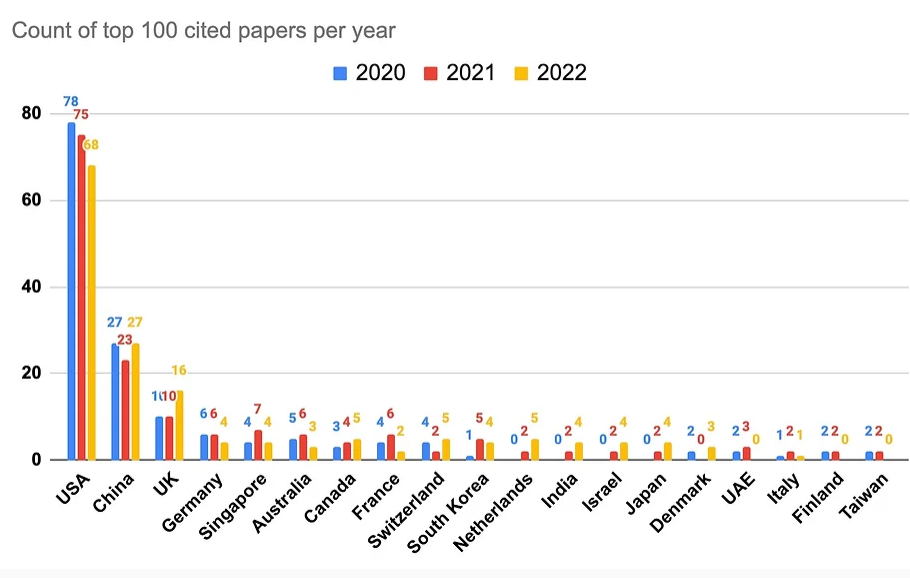

过去三年,按照国家和地区看,100篇引用最多的论文发布的数量如下图所示:

可以看到,100篇引用最多论文的数量最多的就是美国了。不过,近三年总体占比下降趋势,近三年数量分别是78篇、75篇和68篇。第二名就是中国(这里看应该是不包括香港和台湾省),近三年论文分别是27、23和27,数量几乎不变。之前有报告称中国要在AI论文领域取代美国,但是从被引看这个有点夸张了,差距还是很明显的。

二、按照国家和地区角度看论文占比

第一个角度是从数量占比看。现在从比例看如下图所示:

因为共同作者的原因,这里的100篇被引最多论文作者单位应该是不止100的。从比例看,美国从2020年占比的将近80%下降到60%不到。而中国稳定在10%多一点。除此之外,英国是最重要的地区。不过需要注意的是,英国作者贡献的论文中69%都是由DeepMind发布的。而DeepMind是被谷歌收购的研究机构。所以,准确来说,差距更大。

三、按照发布机构看论文占比

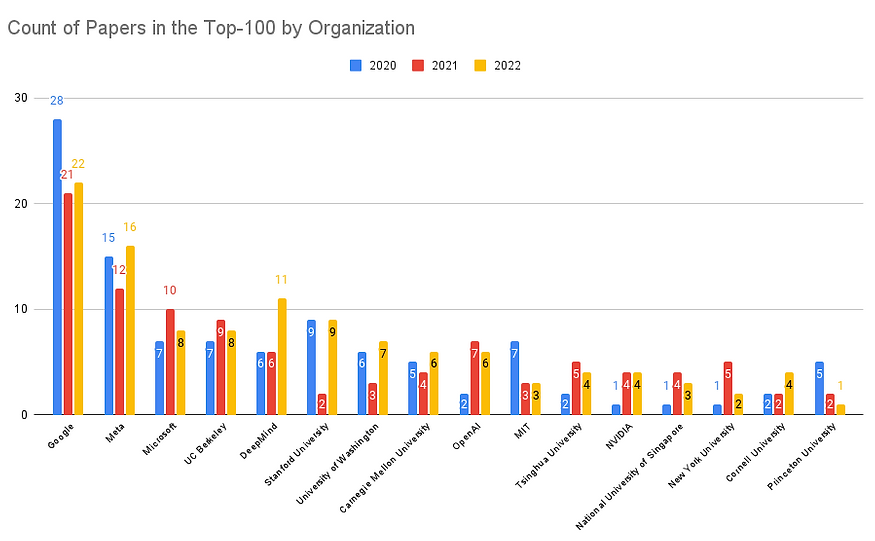

现在从作者单位来看论文数量。情况如下:

从近三年的发布情况看,100篇被引最多的AI论文前三名由企业界的三巨头占据,即美国科技企业谷歌、Meta和微软。而后面的排名中,还有13家单位,高校占比更多。只有3家企业相关机构,包括DeepMind、OpenAI和MIT,但都是美国企业。其中剑桥大学、清华大学和新加坡国立大学大学是剩下10所高校中仅有的3所非美国高校。从这个角度看,美国的企业和高校实力绝对的强。

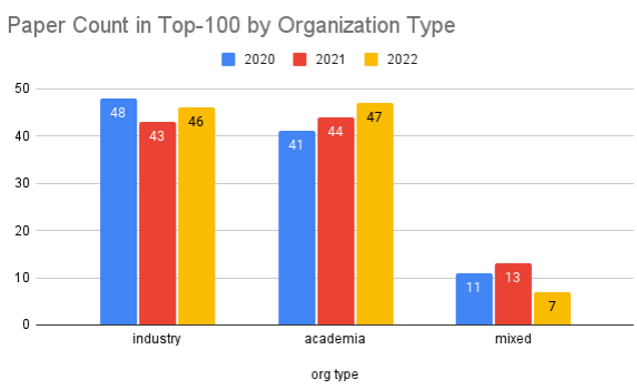

从这个角度看,企业的研究很强,但是集中在头部。而高校虽然单个机构的影响力不如企业,但是加在一起很多。下图展示的是三年不同类别机构占比。

可以看到,工业界和学术界总体影响力差不多。

四、所有论文发表单位排行

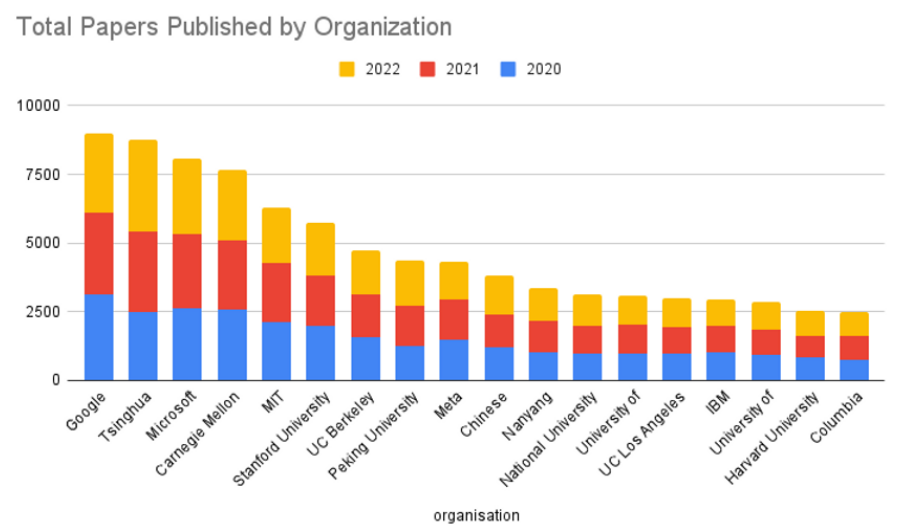

前面分析的都是100篇被引最多的论文。这里再看看所有论文发布结果排序。

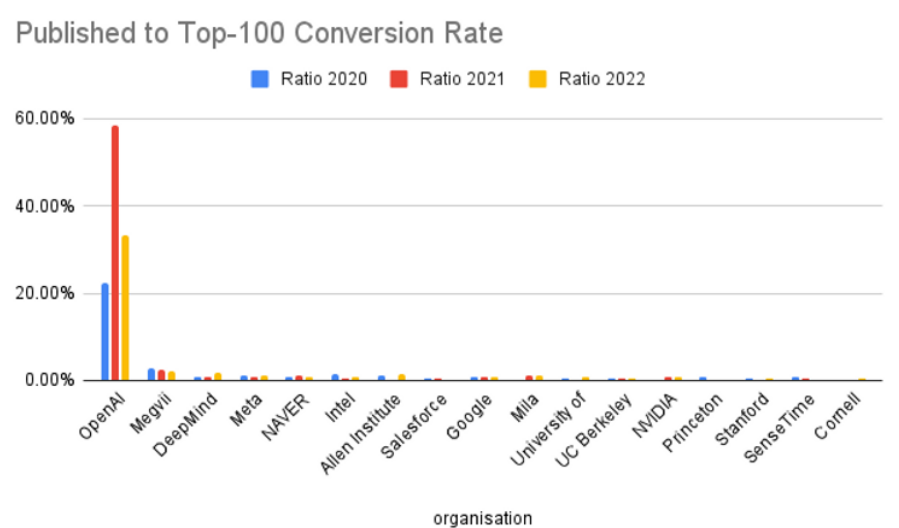

这里看到排名大变样。不过谷歌依然最强。说明谷歌的研究结果不仅影响力大,产量也是惊人。这可能与谷歌庞大的研究机构有关(Google Research简介:https://www.datalearner.com/ai-organizations/google-research )。但是OpenAI、DeepMind这种产出高影响力论文的单位在这里就看不到了。下图展示了哪些机构发布的论文中高影响力论文占比更高。

可以看到,OpenAI绝对的占比第一。也就是说,OpenAI发布的论文一半或者以上都具有很高的影响力。而其他的机构水平都差不多。不过可惜的是,国内的机构和企业均没有上榜。

五、过去三年被引最多的5篇AI论文列表

最后,我们列出过去三年每年被引用最多的5篇AI领域的论文,大家可以看看仔细研读学习!

2022年

-

AlphaFold Protein Structure Database: massively expanding the structural coverage of protein-sequence space with high-accuracy models - 著名的蛋白质结构预测模型,来自DeepMind,被引1372次。

-

ColabFold: making protein folding accessible to all - 开源的蛋白质折叠模型,多家机构共同作者,被引1162次。

-

Hierarchical Text-Conditional Image Generation with CLIP Latents - 来自OpenAI的DALL·E2模型论文,被引718次。

-

A ConvNet for the 2020s - 来自Meta和UC Berkeley,被引690次。在一个transformer统一天下的时代,除了一个卷积网络的性能天花板级别的探索,非常值得一读。

-

PaLM: Scaling Language Modeling with Pathways - 来自谷歌的5400亿参数大模型,被引452次。

2021年

-

**Highly accurate protein structure prediction with AlphaFold ** - 突破性的成果,DeepMind预测蛋白质结构的模型,被引8965次。

-

Swin Transformer: Hierarchical Vision Transformer using Shifted Windows - 来自微软的使用transformer变种做CV的成果,被引4810次。

-

Learning Transferable Visual Models From Natural Language Supervision -> 来自OpenAI的著名CLIP模型,一个自监督的多模态模型,将多模态工作从最近几年的停滞状态做了一个很好的探索,被引3204次。

-

On the Dangers of Stochastic Parrots: Can Language Models Be Too Big? - 来自华盛顿大学论文,对大模型的趋势做了判断,强调了现在的大模型的局限和危险,被引1266次。

-

Emerging Properties in Self-Supervised Vision Transformers - 来自Meta的探索,自监督模型如何让transformer产生原始图像的分割能力,被引1219次。

2020年

-

An Image is Worth 16x16 Words: Transformers for Image Recognition at Scale 谷歌的著名论文,首次展示一个纯粹的transformer模型可以在CV领域获得很好的效果,被引11914次。

-

Language Models are Few-Shot Learners - OpenAI著名的GPT-3模型论文,但是没有细节,被引8070次。

-

YOLOv4: Optimal Speed and Accuracy of Object Detection - 来自台湾的Academia Sinica,YOLO系列最新的模型,被引8014次。

-

**Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer ** - Google关于transformers模型的迁移学习探索,产生了著名的T5模型。被引5906次。

-

Bootstrap your own latent: A new approach to self-supervised Learning - DeepMind and Imperial College展示了表示学习中negatives并不是必须的。被引2873次。

六、2022年AI领域被引最多的论文列表

请查看:https://www.datalearner.com/blog/1051677943057420

数据来源:https://www.zeta-alpha.com/post/must-read-the-100-most-cited-ai-papers-in-2022