最新发布!截止目前最强大的最高支持65k输入的开源可商用AI大模型:MPT-7B!

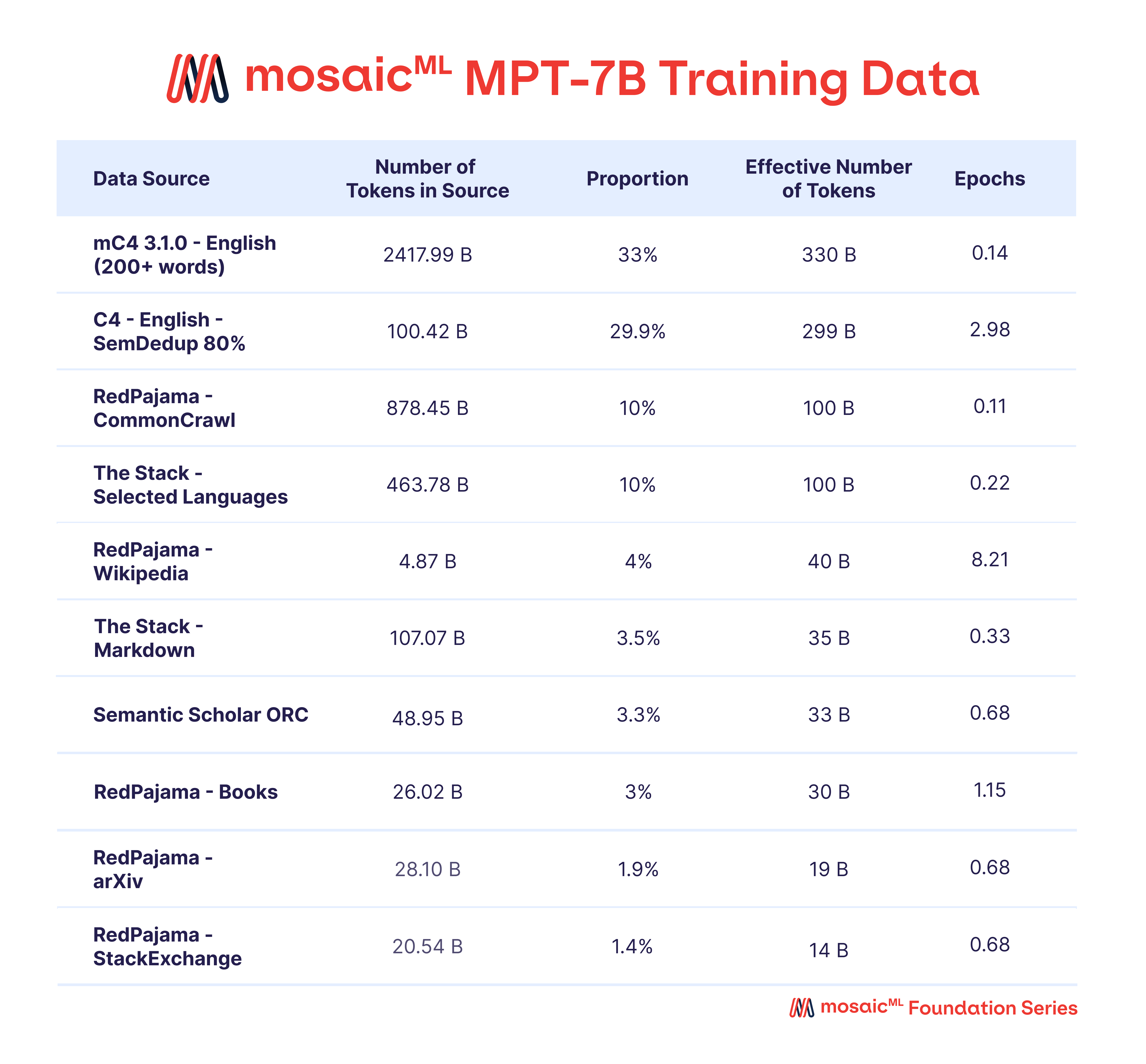

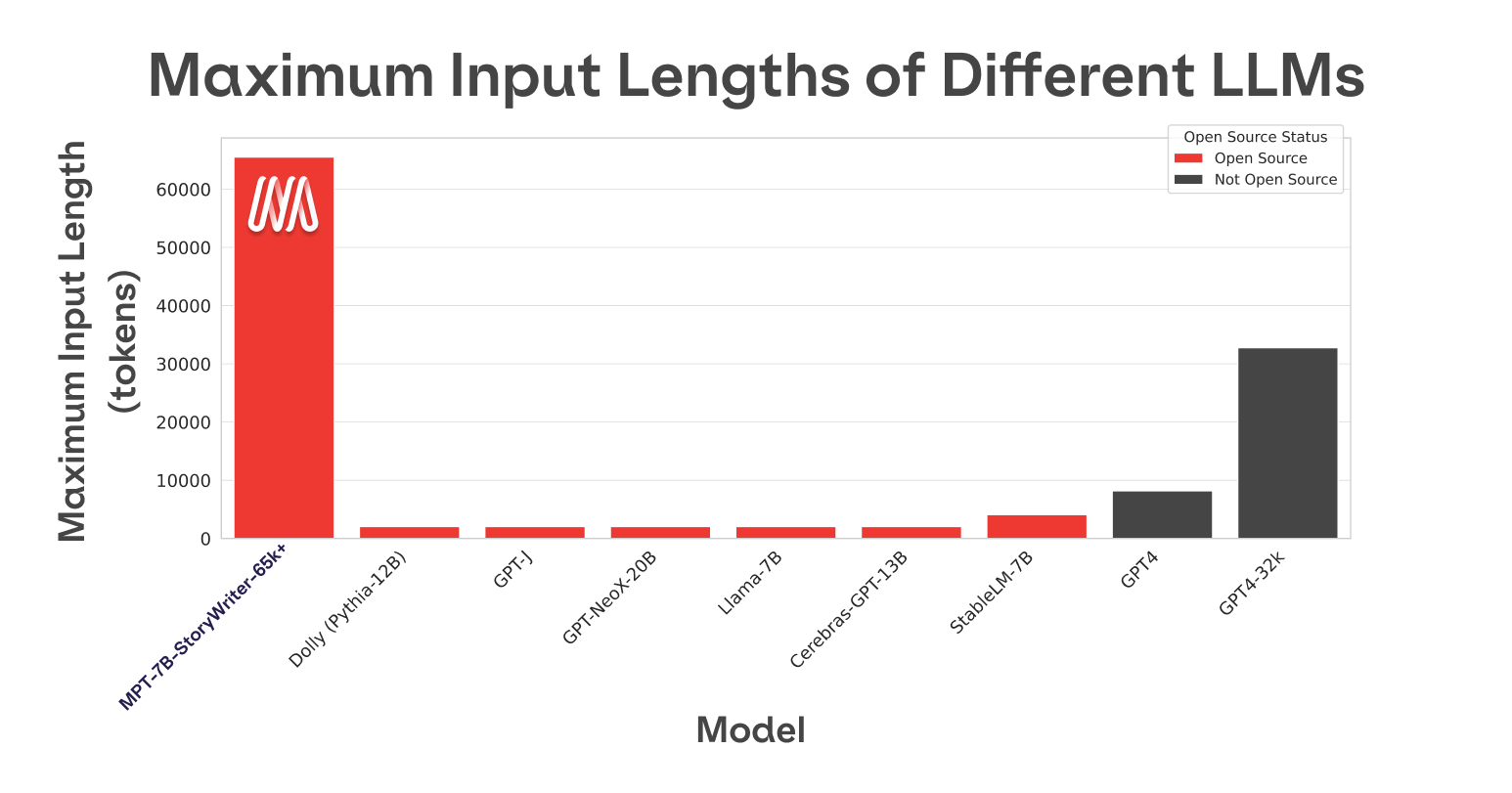

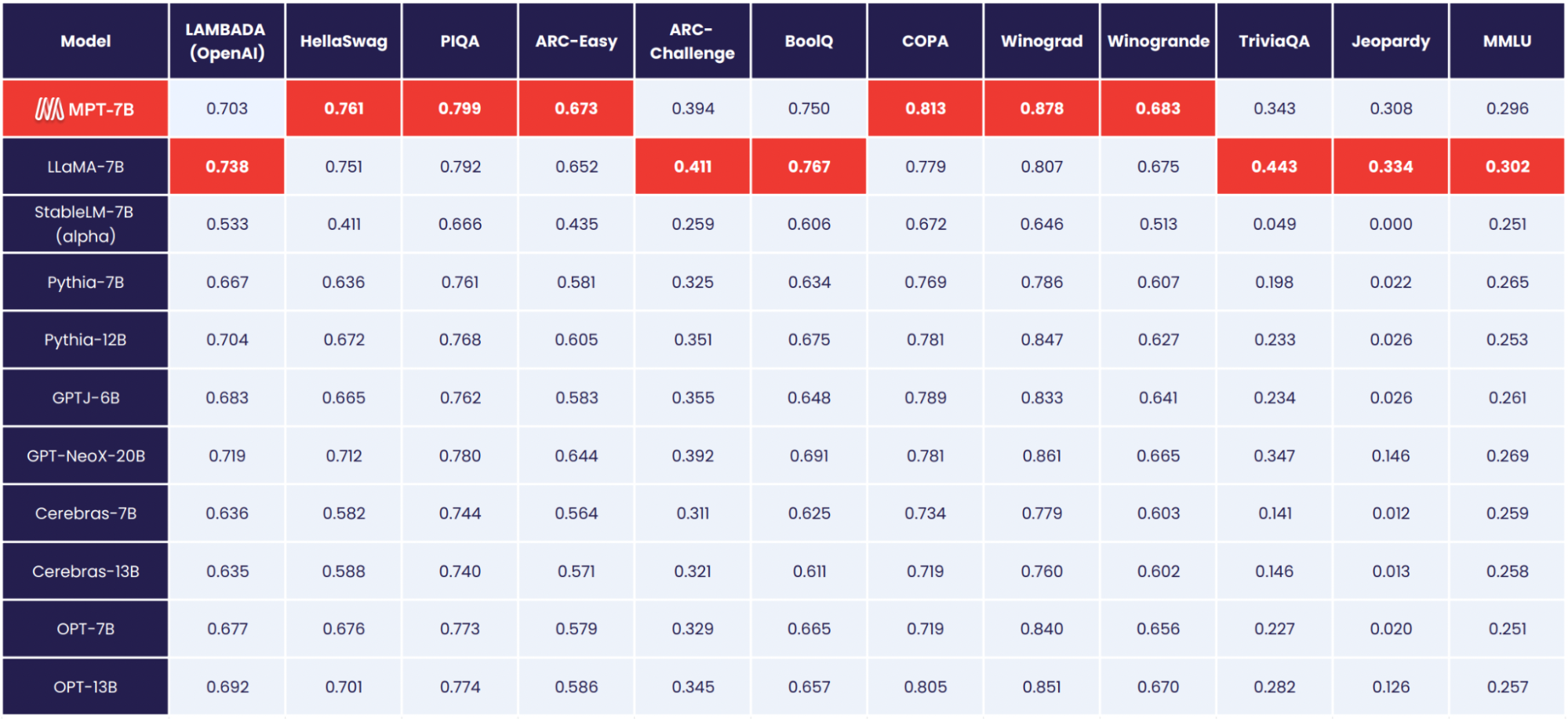

昨天,开源AI模型领域迎来一个重磅玩家,MosaicML发布MPT-7B系列模型,根据官方宣布的测试结果,MPT-7B的水平与MetaAI发布的LLaMA-7B水平差不多,属于当前开源领域最强大的模型。最重要的是,MPT-7B系列中有一个可以支持最多65k上下文输入的开源模型,比GPT-4的32k还高!应该是目前最长的!

目前,MPT-7B模型系列包含4个,其中3个开源可商用,一个是非商用模型。不过,就在今天,因为MPT-7B训练数据的问题也引发了一些人对于它产权的质疑。

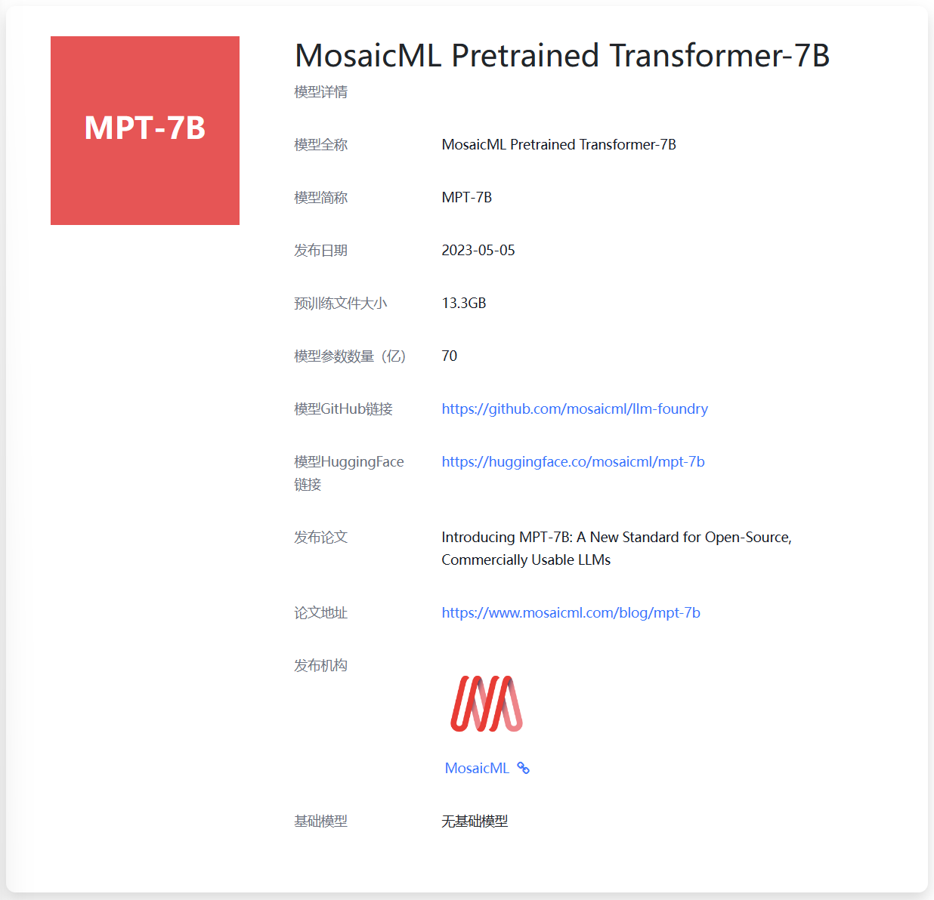

上述截图来自DataLearner官方的MPT-7B模型卡信息:https://www.datalearner.com/ai-models/pretrained-models/MPT-7B

本文将介绍一下MPT-7B模型的信息,以及它受到的一个合规质疑。