强化学习的历史

强化学习(Reinforcement Learning)是近年来十分火热的一种机器学习研究领域。随着DeepMind(谷歌旗下的研究机构)的AlphaGo在围棋界战胜人类之后,这类方法开始被人们广泛关注。但是,强化学习并不是突然出现,也不是DeepMind的首创,在很久之前,这种方法已经开始发展,但是近年来,随着AI相关的软硬件能力的提升,强化学习的实用价值也开始显现。本文不涉及强化学习本身的技术细节,仅仅记录这种方法的历史由来。

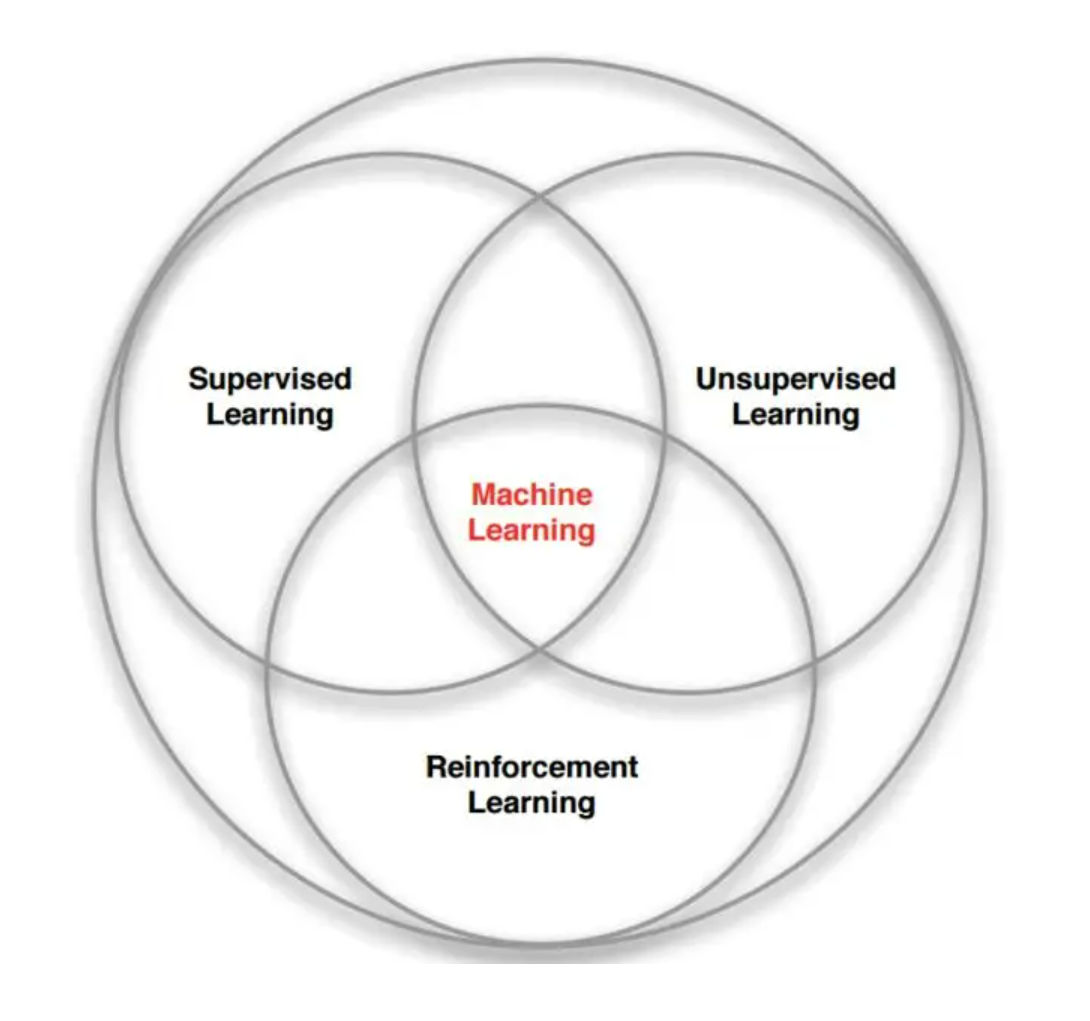

加载中...

强化学习(Reinforcement Learning)是近年来十分火热的一种机器学习研究领域。随着DeepMind(谷歌旗下的研究机构)的AlphaGo在围棋界战胜人类之后,这类方法开始被人们广泛关注。但是,强化学习并不是突然出现,也不是DeepMind的首创,在很久之前,这种方法已经开始发展,但是近年来,随着AI相关的软硬件能力的提升,强化学习的实用价值也开始显现。本文不涉及强化学习本身的技术细节,仅仅记录这种方法的历史由来。

欢迎关注 DataLearner 官方微信,获得最新 AI 技术推送

强化学习这个词最早在20世纪60年代开始出现在工程文献中,其中明斯基(Marvin Minsky,参考:Marvin Minsky - Wikipedia)于1961年发表的论文《Steps Toward Artificial Intelligence》中提出的强化学习一词影响最大。明斯基毕业于普林斯顿大学。1954年,他的博士论文《Theory of neural-analog reinforcement systems and its application to the brain-model problem》发表,其核心内容就是提出了一种解决“brain-model”的新方法(也就是模仿人脑的工作方式来设计计算机算法问题)。在这篇论文中,明斯基提到了“reinforcement operator”、“reinforcement process”、“reinforcement system”等概念以及试错学习等。1961的论文发表之后,强化学习这个词开始被广泛使用。

尽管强化学习是由明斯基于1961年的论文中首次提出,但是这种试错学习在此之前已经开始发展。目前,大家认为强化学习的来源与两个领域密切相关:即心理学中的动物学习和最优控制的优化理论。

心理学中的动物学习也是早期人工智能算法研究的方向之一。早期人工智能的部分研究方向就是努力模仿人类大脑和动物学习的过程来建立模型和算法。其中最重要的一种方式就是试错学习,明斯基的博士论文也算是这一种方向。在20世纪50-60年代,包括明斯基、Clark、Farley等人都在这个方向努力。不过,随后很多强化学习的研究变成了有监督的学习算法,尽管其中也有奖励和惩罚的概念,但实际上却是一种模式识别和感知学习的系统。此后,强化学习的发展并不突出。

这类方法最具代表性的就是Donald Michie提出的解决Tic-Tac-Toe游戏的系统MENACE (Matchbox Educable Naughts and Crosses Engine)。Tic-Tac-Toe就是井字棋游戏,在3×3的面板上,一个画O,一个画X,当某种标记沿着一条直线连起来则该标记者获胜。

心理学的动物试错学习还有一个发展方向也十分值得注意,就是时间差分学习(Temporal-Difference Learning)。它的部分概念来源于动物心理学,借鉴了食物或者疼痛给动物带来的刺激。这块内容并不突出,但是十分重要,是经典的强化学习模型Q Learning的基础工作之一。

最优控制是另一种与强化学习密切相关的研究领域。在上个世纪50年代,最优控制用来描述设计控制器以最小化动态系统随时间推移行为的衡量标准的问题。解决这个问题的方法之一是在20世纪50年代中期由理查德·贝尔曼和其他人通过扩展19世纪哈密尔顿和Jacobi的理论而发展出来的。这种方法使用动力系统状态和值函数或"最佳返回函数"的概念来定义一个函数方程,现在通常被称为贝尔曼方程。通过求解该方程来求解最优控制问题的一类方法被称为动态规划(Bellman, 1957a)。Bellman (1957b)还引入了被称为马尔可夫决策过程(MDP)的最优控制问题的离散随机版本,Ron Howard (1960)设计了MDP的策略迭代方法。所有这些都是现代强化学习理论和算法的基本要素。

最优控制与强化学习的差别一直是很多人疑惑的问题,总的来说,最优控制是一种研究问题,其中的MDP是这类问题的一种描述或者说数学建模。而强化学习是这种问题的一种解决方法,例如有名的Q Learning就是一种经典的强化学习方法,可以用来求解MDP问题。

前面所述的强化学习内容与现代强化学习概念还是有一定差异的。1989年,Chris Watkins提出了Q Learning的模型,它是时间差分与最优控制的结合。也将之前不同强化学习发展的路径统一到了一起。但是这个模型对于状态过多等都无法有效解决。最终,2013年,DeepMind提出了基于深度学习的强化学习模型,即Deep Q Network,并在2015年发表了改进版本。至此,强化学习进入了大众的视野。

参考: http://www.incompleteideas.net/book/ebook/node12.html https://www.zhihu.com/question/419842434 https://www.zhihu.com/question/23995189 https://www.zhihu.com/question/26408259 https://zhuanlan.zhihu.com/p/97856004 https://researchdatapod.com/history-reinforcement-learning/